미라 무라티(Mira Murati) 전 오픈AI 최고기술책임자(CTO)가 설립한 AI 스타트업 씽킹머신스랩(Thinking Machines)이 인공지능 모델 미세 조정 서비스 ‘팅커(Tinker)’의 일반 공개(General Availability)를 발표하며 상용화에 나섰다.

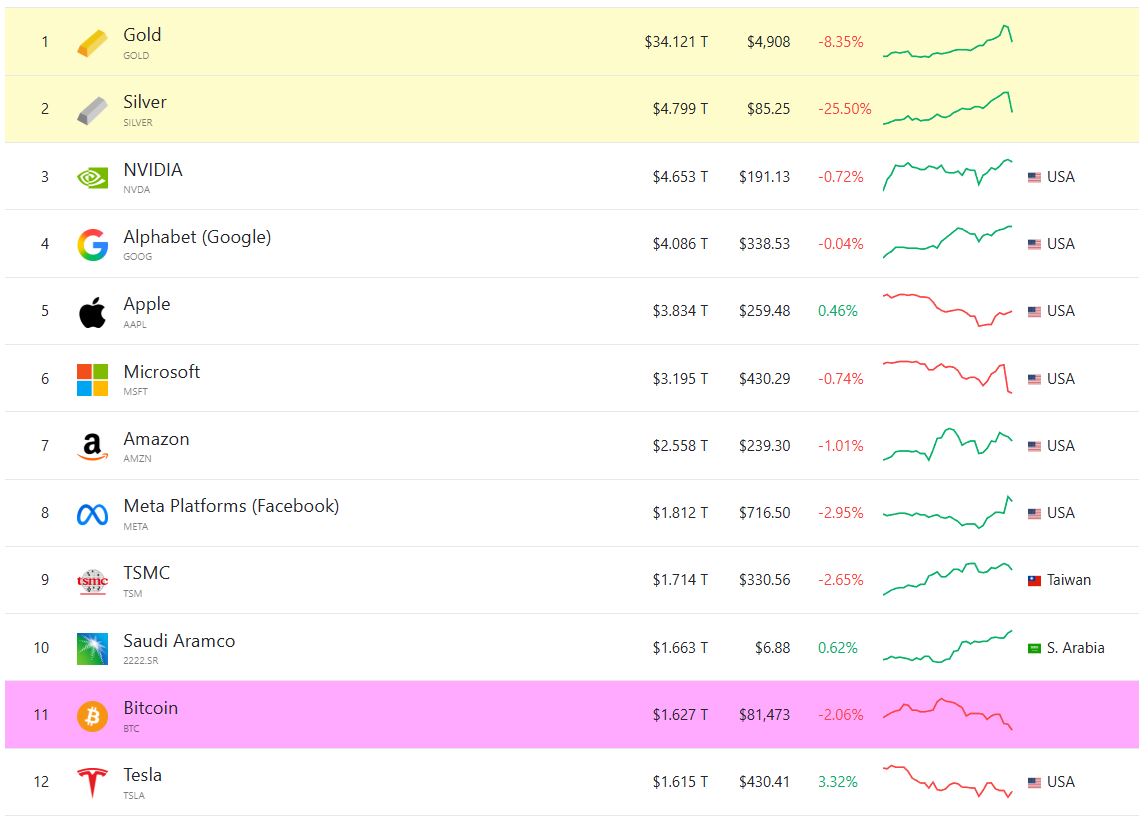

실리콘밸리 기반의 씽킹머신스는 지난 2월 창립된 이후, 불과 10개월 만에 팅커의 초기 버전 공개를 거쳐 본격적인 제품화를 이뤄냈다. 이 회사는 이미 지난 6월 20억 달러(약 2조 8,800억 원)의 시드 투자 유치에 성공했으며, 이 과정에서 엔비디아(NVDA), AMD(AMD), 서비스나우(NOW) 등 기술 업계의 주요 플레이어들이 투자자로 참여해 화제를 모았다. 최근에는 메타(META)에서 파이토치(PyTorch)를 공동 개발한 수미스 친탈라(Soumith Chintala)를 영입하며 기술 역량을 대폭 강화했다.

팅커는 대규모 언어모델(LLM)을 특정 작업에 최적화하는 ‘미세 조정(Fine-Tuning)’ 과정을 효율화한 클라우드 서비스다. 기존 방식이 전체 모델 파라미터를 재조정하는 방식이라면, 팅커는 ‘로우 랭크 어댑테이션(Low-Rank Adaptation, LoRA)’ 기법을 채택해 훨씬 적은 연산 자원으로 빠르게 실행 가능한 것이 강점이다. LoRA는 모델에 소수의 보조 파라미터를 덧붙이고 이 부분만 학습시켜 속도와 비용을 대폭 절감할 수 있도록 설계됐다.

팅커의 LoRA 구현은 효율성과 품질을 두루 확보했다는 평가를 받는다. 통상 LoRA 방식은 결과물의 정밀도가 낮아지는 한계가 있었지만, 팅커는 기존 방식과 유사한 수준의 출력 품질을 제공할 수 있다고 회사는 강조한다. 또한 다수 GPU를 활용하려면 전문가 수준의 코드 최적화가 필요하던 기존 시스템과 달리, 파이썬 스크립트 한 줄로도 다중 GPU 환경에서 자동 실행까지 가능하도록 설계돼 접근성을 높였다.

이 외에도 학습 중간 데이터를 주기적으로 저장해 장애 발생 시 마지막 안정 지점으로 롤백할 수 있는 기능, 테스트 프롬프트를 실시간으로 입력해 응답을 확인하고 조정할 수 있는 샘플링 도구 등 다양한 부가기능이 함께 제공된다.

모델 지원 범위도 대폭 확대됐다. 파라미터 수 1조 개에 달하는 키미 K2(Kimi K2)는 실행 환경과의 복잡한 상호작용에 특화돼 있어 한 세션에서 최대 300개의 툴 호출이 가능하다. 또 시각 모델인 Qwen3-VL-30B-A3B-Instruct는 경량화된 구조로 경량 장비에 적합하고, Qwen3-VL-235B-A22B-Instruct는 대규모 입력 데이터를 처리할 수 있는 넓은 콘텍스트 창을 강점으로 갖는다.

씽킹머신스는 현재 추가적인 투자 유치를 위한 행보도 본격화하고 있다. 최근 보도에 따르면, 회사는 50억 달러(약 7조 2,000억 원) 규모의 신규 펀딩 라운드를 추진 중이며, 기업가치는 500억 달러(약 72조 원)에 이를 전망이다. 시장 일각에서는 이를 발판 삼아 팅커 외에도 다양한 AI 툴링 플랫폼 인수와 신제품 출시가 이어질 것으로 보고 있다.

미세 조정과 LLM 효율화는 차세대 생성형 AI 경쟁의 핵심 기술로 부상하고 있으며, 이를 통해 고도로 특화된 엔터프라이즈 솔루션 개발에도 속도가 붙을 것으로 기대된다. 이런 흐름 속에서 팅커의 상용화는 AI 산업의 다음 단계로 나아가는 이정표가 될 것으로 평가받고 있다.

1

1

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 523회차](https://f1.tokenpost.kr/2026/01/qokpmpceok.png)

![[토큰포스트] 기사 퀴즈 522회차](https://f1.tokenpost.kr/2026/01/aims5420dh.jpg)

![[토큰포스트] 기사 퀴즈 521회차](https://f1.tokenpost.kr/2026/01/f2femcntpq.jpg)

![[토큰포스트] 기사 퀴즈 520회차](https://f1.tokenpost.kr/2026/01/y648ak216n.jpg)