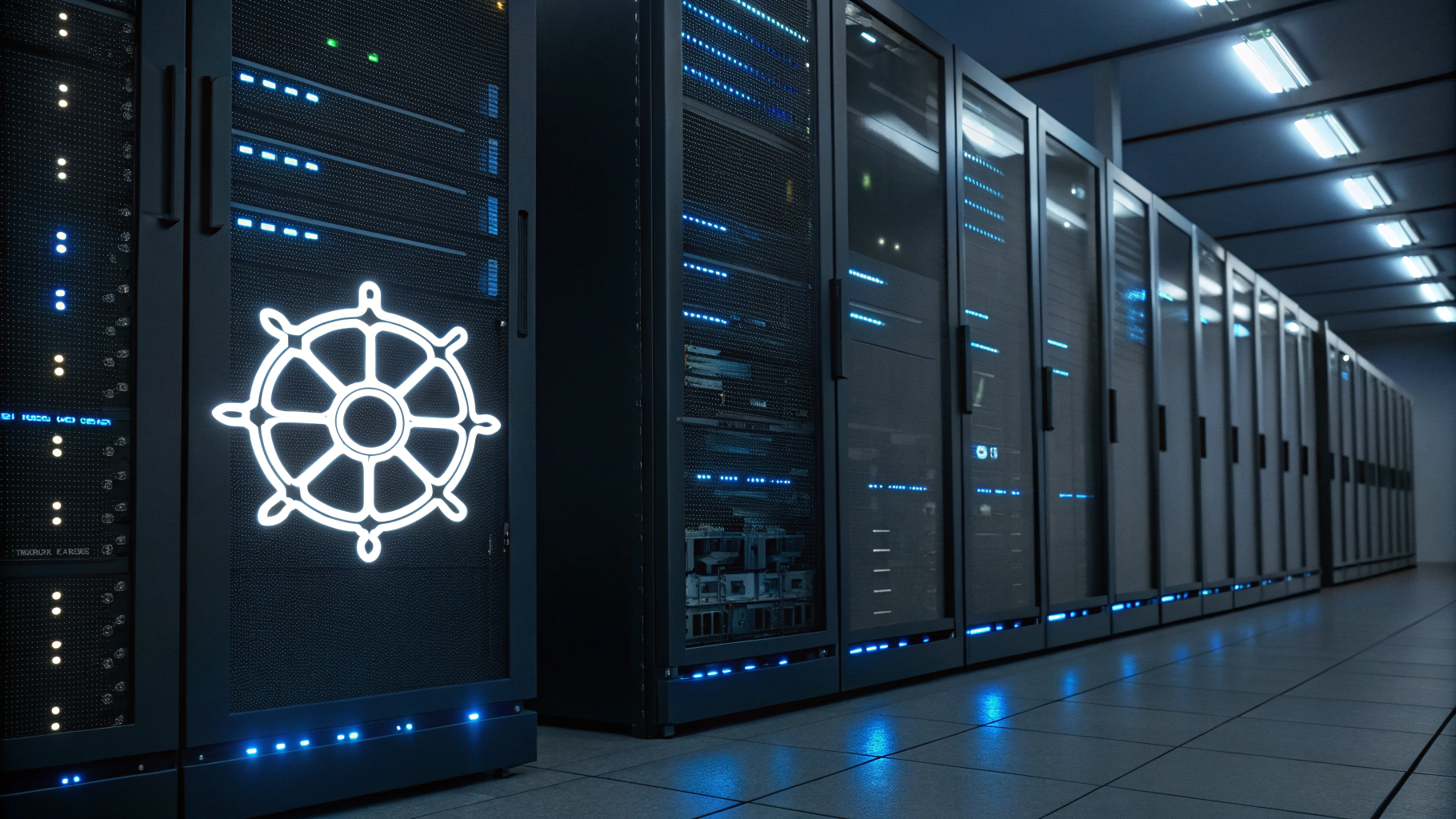

AI 인프라 구축의 새로운 기준으로 떠오른 구글 클라우드의 GKE(Google Kubernetes Engine)가 생성형 AI 확산에 결정적 전환점을 제시하고 있다. AI 추론 워크로드를 효율적으로 처리하고자 하는 기업들의 수요가 빠르게 증가하면서, GKE는 클라우드 기반 AI 인프라 시장에서 핵심 플랫폼으로 자리 잡고 있다.

구글 클라우드에 따르면, GKE는 단순한 컨테이너 오케스트레이션 툴 수준을 넘어 AI 운영의 기초 인프라로 진화하고 있다. GKE의 유연한 실행 환경, 다양한 라이브러리 지원, 그리고 친숙한 설정 방식은 기존 웹 개발 환경과 닮아 있어 개발자 및 엔지니어층의 진입 장벽을 낮췄다는 평가다. 에디 비야바(Eddie Villalba) 구글 클라우드 제품 매니저는 AI를 단순히 또 하나의 컴퓨팅 워크로드로 보며, 이를 어떻게 배치하고 확장하느냐가 인프라 관건이라고 강조했다. 특히 그는 "AI가 특수한 형태의 워크로드라면 GKE는 그 요구에 맞춰 정교하게 진화한 플랫폼"이라고 설명했다.

Poonam Lamba 구글 클라우드 GKE AI 추론 책임자는 GKE의 핵심 강점으로 컨테이너화된 추론 모델의 이식성과 일관된 운영 환경을 꼽았다. 예를 들어, 텐서플로우나 파이토치, JAX 같은 프레임워크 기반 모델과 그 실행 구성을 컨테이너 단위로 묶어 테스트 환경에서 프로덕션까지 손쉽게 이동할 수 있다는 점이 기업의 AI 개발 주기를 대폭 단축한다고 설명했다.

또한 GKE는 대규모 병렬 처리, 모델 버전 관리, 큐 관리 등 고성능 AI 워크로드에 특화된 기능을 여럿 탑재하고 있다. 최근 선보인 GKE 인퍼런스 게이트웨이(Inference Gateway)는 AI 추론에 최적화된 로드밸런서로, 전통적인 상태 비저장 라우팅을 넘어 모델 버전 지정, 요청 중요도 분류, 캐시 사용률, 대기열 분석 등 다양한 실시간 데이터를 반영해 요청들을 더욱 똑똑하게 분산 처리한다.

이를 통해 기업은 임계 요청을 우선 처리하고, 중요도가 낮은 요청은 드랍하거나 대기열에 넣을 수 있는 정교한 대응이 가능해졌다. 이는 AI 기반 서비스 환경에서 사용자 경험 혁신에 직결되는 포인트다.

여기에 더해 GKE는 사용자가 직접 원하는 성능 및 비용 수준을 지정할 수 있는 '커스텀 컴퓨트 클래스'(Custom Compute Classes)와, 효율적 자원 할당을 위한 '다이내믹 워크로드 스케줄러'도 지원하고 있다. 이러한 기능들은 GPU나 TPU와 같은 AI 특화 가속기를 워크로드 별로 적시에 할당할 수 있게 해, 계산 자원의 유연성과 이용 효율을 크게 끌어올렸다.

에디 비야바는 이를 고급 요리를 위한 주방에 비유했다. 다양한 요리를 만들기 위해 다양한 장비가 필요한 것처럼, AI 추론을 안정적으로 실행하려면 다양한 연산 자원을 갖춘 유연한 인프라가 필수라는 것이다. 그는 "GKE는 단순한 웹 서비스부터 고난도 모델 추론까지, 마치 최고급 요리부터 샐러드까지 모두 소화할 수 있는 주방처럼 구성되어 있다"고 말했다.

클라우드 네이티브 환경에서 AI 워크로드를 확장하려는 모든 기업에게 GKE는 인프라 수준에서의 불확실성을 줄이고, 성능과 운영 효율성이라는 두 마리 토끼를 잡을 수 있는 전략적 선택지로 부상하고 있다. 대규모 AI 시스템의 서비스 현실화가 중요한 과제로 자리한 지금, GKE는 그 해답이 될 수 있음을 이번 행사를 통해 분명히 보여줬다.

1

1

![[자정 시세브리핑] 암호화폐 시장 상승세… 비트코인 69,761달러, 이더리움 2,085달러](https://f1.tokenpost.kr/2026/02/9ukwjqr0m7.jpg)

![[자정 뉴스브리핑] X, 암호화폐·주식 거래 기능 출시 예정 外](https://f1.tokenpost.kr/2026/02/nhf4jnc11k.jpg)

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 534회차](https://f1.tokenpost.kr/2026/02/qetvwueue8.webp)

![[토큰포스트] 기사 퀴즈 533회차](https://f1.tokenpost.kr/2026/02/yxki8fbsgk.webp)

![[토큰포스트] 기사 퀴즈 532회차](https://f1.tokenpost.kr/2026/02/geibni8f8j.jpg)

![[토큰포스트] 기사 퀴즈 530회차](https://f1.tokenpost.kr/2026/02/wzoyk1y2ly.jpg)