엔비디아가 인공지능(AI) 서버 구조의 핵심 병목 요소로 '메모리 처리 능력'을 지목하면서, 일반 D램과 낸드플래시 등 기존 메모리 반도체의 수요가 함께 늘어날 가능성이 커지고 있다. 특히 연산량이 폭증하는 AI 추론 작업의 특성상, 고대역폭메모리(HBM) 외에도 다양한 메모리 자원이 통합적으로 작동해야 하는 구조로 전환되고 있다는 게 업계의 분석이다.

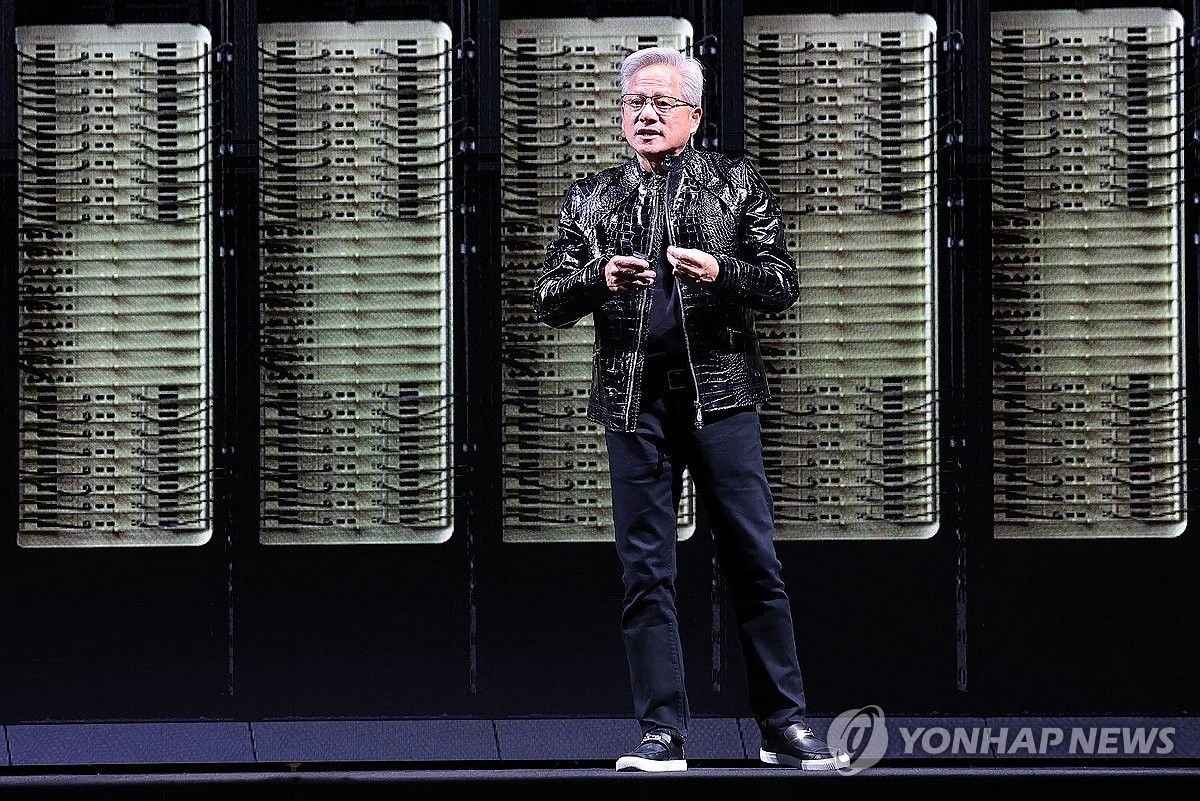

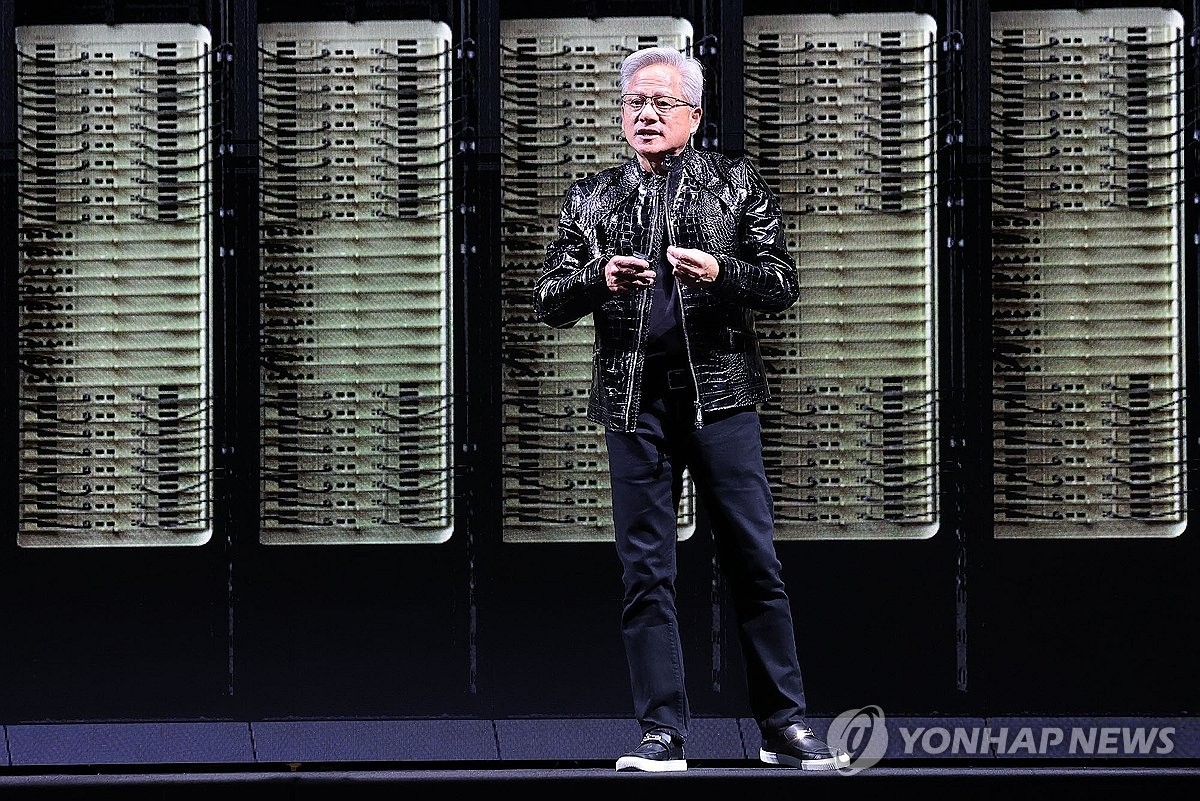

이번 평가의 배경은 젠슨 황 엔비디아 최고경영자가 미국 라스베이거스에서 열린 CES 2026 키노트 연설에서 언급한 내용을 기반으로 한다. 황 CEO는 AI 산업이 2026년에도 강력한 성장세를 이어갈 것으로 전망했으며, 이 과정에서 메모리 용량과 대역폭 부족이 기술적인 병목 지점이라고 지적했다. 이에 따라 GPU(그래픽처리장치) 위주였던 서버 아키텍처가 D램·낸드 등 다양한 메모리 계층을 포괄하는 방식으로 확대되고 있다는 분석이 나온다.

삼성증권은 이런 변화의 중심에 있는 것이 '에이전트 AI'라고 설명했다. 에이전트 AI란 다양한 환경에서 AI가 자체 판단으로 상황에 대응하는 기술로, 기존 모델보다 훨씬 많은 양의 데이터를 빠르게 처리해야 한다. 이로 인해 AI 모델의 추론(Inference) 단계에서 연산 호출 횟수와 데이터 시퀀스 길이가 급증하면서, 이를 처리할 수 있는 충분한 메모리 대역폭과 용량이 필수 조건이 되고 있다.

이런 흐름을 반영하듯, 엔비디아는 자사 AI 서버 시스템 내에 블루필드-4 DPU(데이터처리장치)를 포함한 스토리지 메모리 아키텍처를 새롭게 제시했다. 여기서는 고대역폭메모리(HBM)에 국한되지 않고, 저전력 D램(LPDDR), NVMe 기반 고용량 낸드까지 모두 계층 캐시로 사용하는 구조가 도입된다. 특히 'KV 캐시'(Key-Value Cache)라는 연산 처리 구조를 GPU와 직접 연결된 형태로 운용함으로써, 시스템 전반의 효율성을 획기적으로 높이는 데 초점이 맞춰져 있다.

향후 AI 서버 한 대에 탑재되는 메모리와 스토리지의 규모는 더욱 커질 것으로 예측된다. 이는 GPU 연산 성능의 증가 속도 이상으로 메모리 콘텐츠의 필요량이 증가할 수 있음을 의미한다. 엔비디아의 메시지는 결국 AI 연산 구조의 핵심 축이 GPU만이 아니라 메모리와 스토리지 자원 간 조화로운 통합에 있다는 점을 강조하는 셈이다.

이러한 변화는 중장기적으로 반도체 산업의 구조적 수요 지형을 바꿀 가능성이 있다. 고성능 메모리를 중심으로 한 기존 수요 외에, 일반 D램과 대용량 낸드플래시 등 폭넓은 메모리 제품군의 동반 성장이 이뤄질 수 있으며, 이는 국내 메모리 반도체 업계에도 긍정적 영향을 줄 것으로 분석된다.

1

1

![[크립토 인사이트 EP.20] 비트코인 4만8천달러 시나리오 vs M2 재확장…공포 속 데이터는 무엇을 말하나](https://f1.tokenpost.kr/2026/02/we0wgyifi8.jpg)

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 540회차](https://f1.tokenpost.kr/2026/02/s74dobfws9.jpg)

![[토큰포스트] 기사 퀴즈 539회차](https://f1.tokenpost.kr/2026/02/celz7zpk2n.jpg)

![[토큰포스트] 기사 퀴즈 538회차](https://f1.tokenpost.kr/2026/02/jxqkx5yb5c.jpg)

![[토큰포스트] 기사 퀴즈 537회차](https://f1.tokenpost.kr/2026/02/4twwawrak9.jpg)