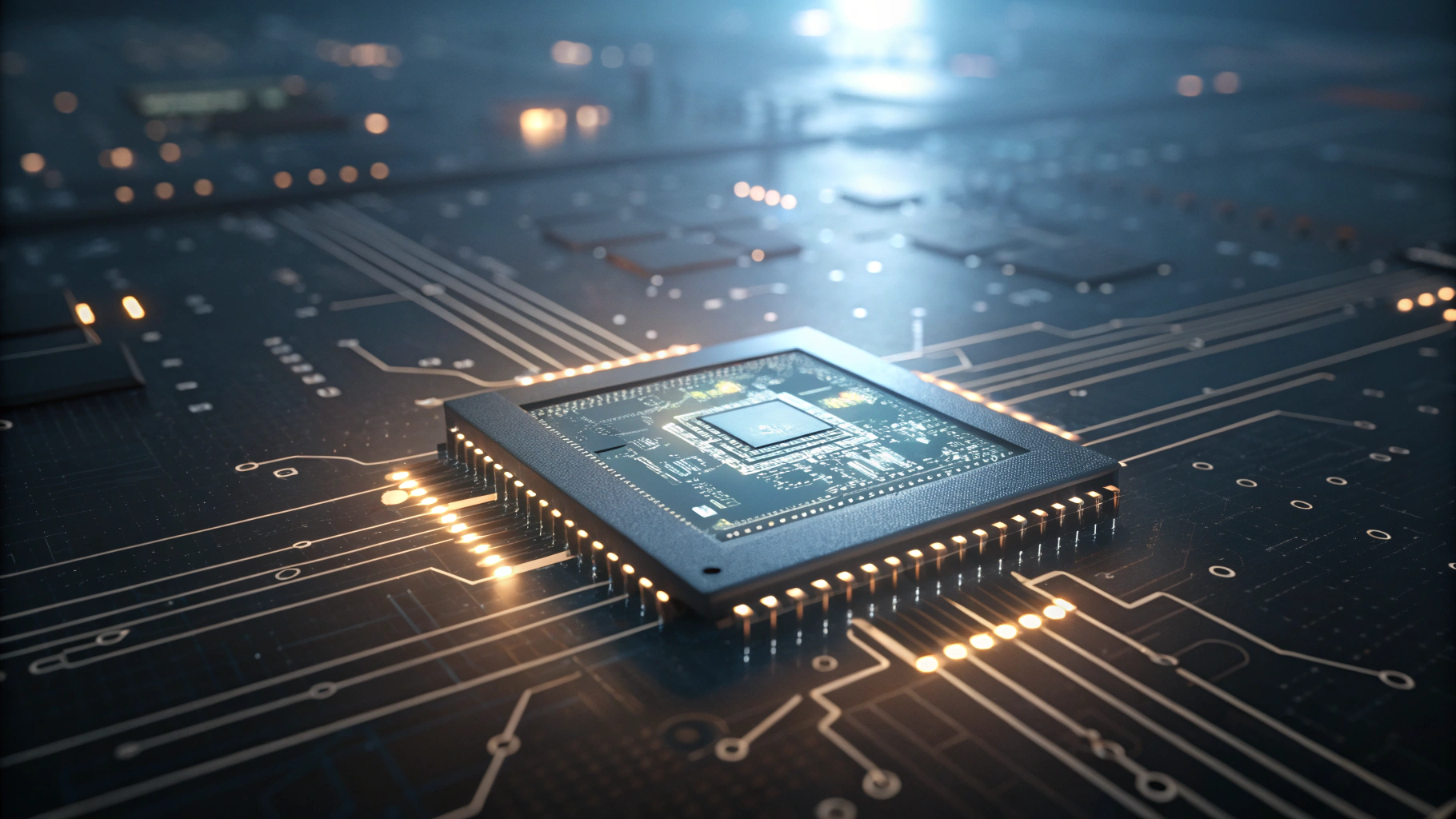

알리바바 그룹이 GPT-5.2와 클로드 4.5 오퍼스를 능가하는 인공지능 모델 Qwen3.5를 발표했다. 이 새로운 알고리즘은 오픈소스 라이선스로 허깅 페이스에 공개되어 있으며, 기본적으로 262,144개의 토큰을 처리할 수 있다. 또한 개발자들은 맞춤화를 통해 이 수치를 거의 네 배까지 늘릴 수 있다. Qwen3.5는 210개 이상의 언어와 방언의 텍스트뿐 아니라 데이터 시각화 같은 이미지를 포함한 프롬프트를 처리할 수 있다.

Qwen3.5는 다양한 작업에 최적화된 여러 신경망으로 구성된 '전문가 혼합 모델'로서, 프롬프트를 받으면 10개의 신경망을 활용해 답변을 생성한다. 이러한 접근 방식은 모든 인공 뉴런을 사용할 필요가 없기 때문에 하드웨어 효율이 높다. 이 모델은 총 3,970억 개의 파라미터를 가지며, 프롬프트 당 170억 개가 사용된다.

모델은 하드웨어 효율을 혁신적으로 개선하기 위해 여러 최적화 기법도 도입했다. 일반적으로 대형 언어 모델의 주의력 메커니즘은 데이터 양에 따라 메모리 필요량이 기하급수적으로 증가하나, Qwen3.5는 메모리 소모를 크게 줄이는 선형 주의 메커니즘을 사용한다. 또한 게이트 델타 네트워크라는 기술을 적용해 LLM이 필요하지 않은 데이터를 메모리에서 제거함으로써 하드웨어 사용을 줄이고, 델타 규칙이라는 학습 알고리즘을 통해 파라미터 업데이트 과정을 최적화한다.

알리바바는 Qwen3.5가 GPT-5.2와 클로드 4.5 오퍼스를 비롯한 다양한 벤치마크에서 우수한 성능을 보였다고 밝혔다. 다중 모드 데이터 처리에도 능하여, 이미지 분석에 특화된 Qwen3-VL 모델을 여러 시각적 추론 및 코딩 벤치마크에서 능가한 것으로 나타났다.

1

1

![[자정 뉴스브리핑] 블랙록, 기관투자가의 비트코인 매수 증가 확인 外](https://f1.tokenpost.kr/2026/02/qdsldhqsdd.jpg)

![[자정 시세브리핑] 암호화폐 시장 혼조세… 비트코인 68,497달러, 이더리움 1,980달러](https://f1.tokenpost.kr/2026/02/wsotejj58w.jpg)

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 535회차](https://f1.tokenpost.kr/2026/02/h11k1htgnt.jpg)

![[토큰포스트] 기사 퀴즈 534회차](https://f1.tokenpost.kr/2026/02/qetvwueue8.webp)

![[토큰포스트] 기사 퀴즈 533회차](https://f1.tokenpost.kr/2026/02/yxki8fbsgk.webp)

![[토큰포스트] 기사 퀴즈 532회차](https://f1.tokenpost.kr/2026/02/geibni8f8j.jpg)