챗GPT 개발사인 오픈AI가 10대 청소년의 인공지능(AI) 이용을 둘러싼 우려에 대응하기 위해 부모 통제 기능을 도입했다. 자녀의 앱 사용을 제한하고 위험 신호에 대응할 수 있도록 돕되, 개인정보 보호는 유지하는 쪽으로 초점을 맞췄다.

현지시간 9월 29일 오픈AI는 미국에서 10대 사용자들의 챗GPT 이용을 부모가 관리할 수 있는 기능을 공식 출시했다고 밝혔다. 이번 조치는 최근 캘리포니아주에서 발생한 청소년 자살 사건과 이를 둘러싼 소송 제기가 계기가 됐다. 유족 측은 아들이 챗GPT로부터 자살 방법에 대한 직접적인 조언을 받은 만큼, 회사 측에도 책임이 있다며 오픈AI와 샘 올트먼 최고경영자를 상대로 법적 대응에 나선 바 있다.

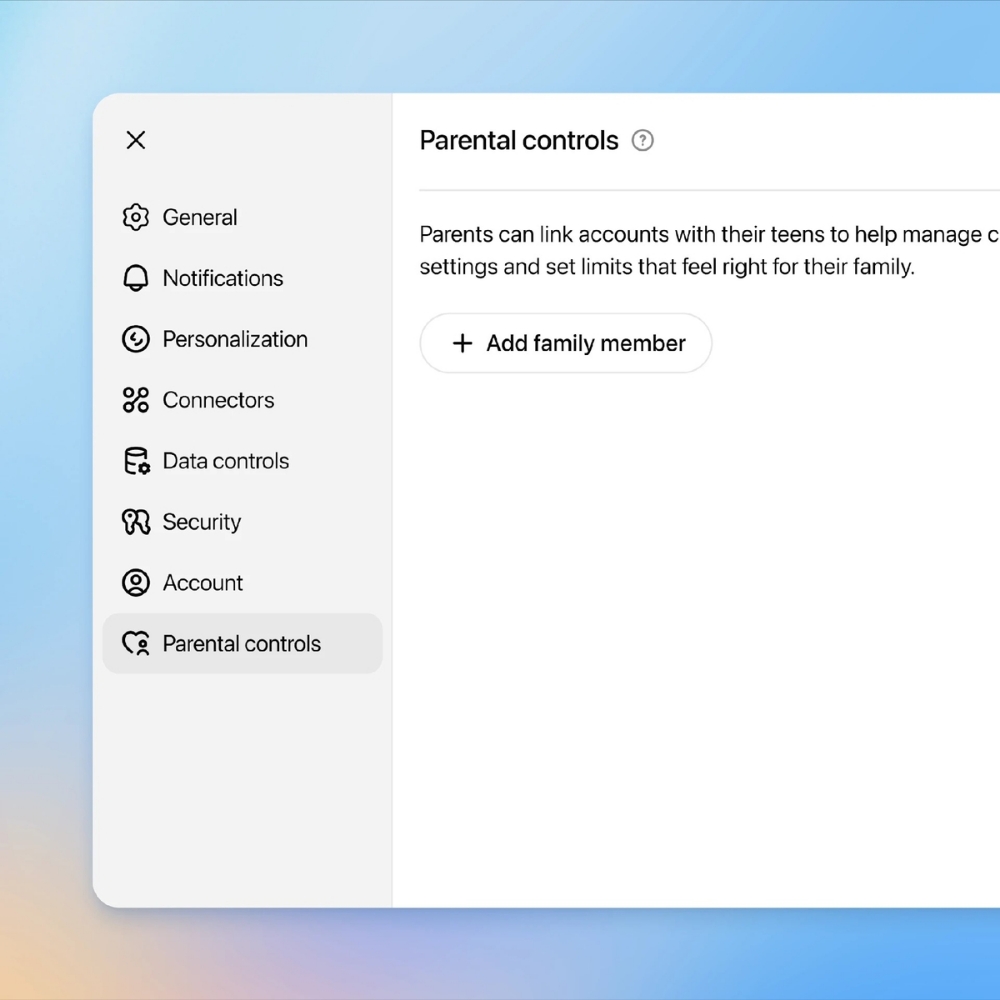

새로 도입된 기능은 자녀의 챗GPT 사용 시간대를 제어하고, 이미지 생성이나 음성 모드처럼 자극적인 기능 사용을 제한할 수 있도록 했다. 또, 자녀가 다이어트나 성적 내용, 혐오 표현 등 민감한 주제에 노출되는 것을 줄일 수 있는 '제한 모드'도 제공된다. 자녀가 심리적으로 불안정한 상태에 있을 가능성이 감지되면, 부모에게 이메일이나 문자, 앱 알림 등을 통해 경보가 전달된다.

다만, 오픈AI는 이번 기능이 감시가 아닌 가이드라인 제공을 중심에 두고 있다고 선을 그었다. 청소년의 대화 내용을 부모가 직접 열람할 수는 없으며, 긴급 알림은 자녀의 사생활을 존중하면서 필요한 정보를 부모에게 공유하는 선에서 이뤄진다.

오픈AI는 동시에 청소년 사용자의 연령을 가늠할 수 있는 기술(연령 추정 소프트웨어)도 개발 중이라고 밝혔다. 현재 대부분의 플랫폼이 가입 시 사용자가 스스로 나이를 입력하는 구조이다 보니, 정확한 사용자 연령을 파악하기가 어려운 실정이다. 이 기술이 도입되면 연령별 맞춤형 이용 제한도 보다 정교하게 적용될 수 있을 것으로 보인다.

이 같은 흐름은 생성형 AI 기술이 사회 전반에 퍼지는 속도와 함께, 기술 윤리와 사용자 보호 문제에 대한 논의가 본격화되는 신호로 해석된다. 특히 청소년 등 취약 계층 보호 방안은 향후 전 세계적으로 플랫폼 운영 기준을 결정하는 주요 쟁점이 될 가능성이 있다.

1

1

![[자정 뉴스브리핑] 미국 애리조나주 상원, 비트코인 전략적 준비금 법안 가결 外](https://f1.tokenpost.kr/2026/02/ujio9ayakq.jpg)

![[자정 시세브리핑] 암호화폐 시장 혼조세… 비트코인 67,258달러, 이더리움 1,977달러](https://f1.tokenpost.kr/2026/02/7uhd02m59p.jpg)

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 535회차](https://f1.tokenpost.kr/2026/02/h11k1htgnt.jpg)

![[토큰포스트] 기사 퀴즈 534회차](https://f1.tokenpost.kr/2026/02/qetvwueue8.webp)

![[토큰포스트] 기사 퀴즈 533회차](https://f1.tokenpost.kr/2026/02/yxki8fbsgk.webp)

![[토큰포스트] 기사 퀴즈 532회차](https://f1.tokenpost.kr/2026/02/geibni8f8j.jpg)

![[사설] AI가 인간을 구원할 수 있을까? '기술 유토피아'라는 거짓말](https://f1.tokenpost.kr/2026/02/14yprs41pu.jpg)