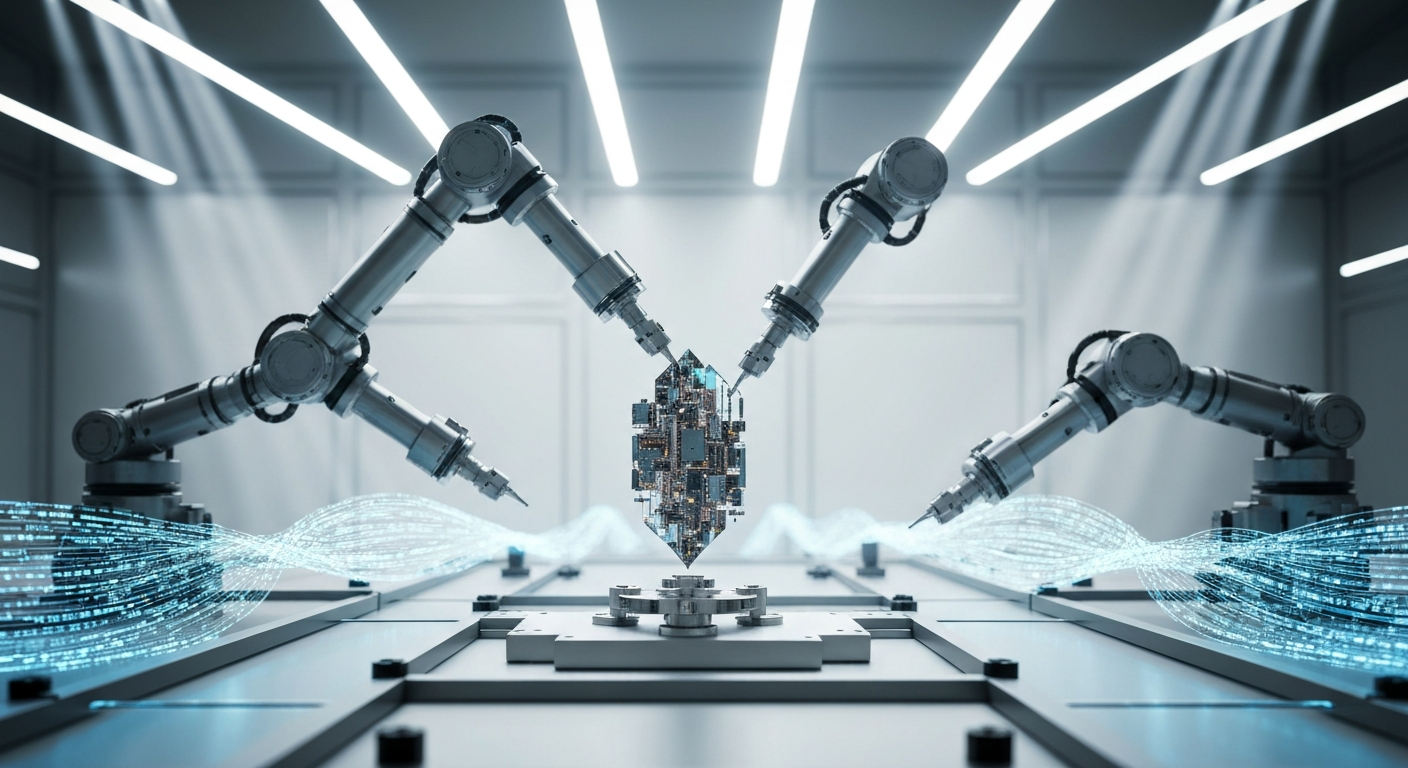

AI 기술이 실제 서비스 환경에서 기대만큼의 성능을 발휘하지 못하면서, 이를 근본적으로 개선하기 위한 새로운 평가 도구가 주목받고 있다. 미국 시애틀에 위치한 앨런 인공지능연구소(Ai2)는 최근 모델 성능을 보다 종합적으로 평가할 수 있는 '리워드벤치 2(RewardBench 2)'를 공개하며 AI 모델 개발의 *실용성 강화*를 선언했다.

RewardBench 2는 대규모 언어모델(LLM)의 출력물을 평가하는 ‘리워드 모델(Reward Model, RM)’의 성능 검증을 위한 벤치마크 툴이다. RM은 인간 피드백을 활용한 강화 학습(RLHF) 과정에서, 모델의 응답에 점수를 부여함으로써 학습 방향을 제시하는 심판 역할을 맡는다. Ai2는 RewardBench 2를 통해 이러한 RM들이 실제 기업 환경에서 인간 판단과 얼마나 잘 일치하는지를 측정할 수 있도록 설계했다.

Ai2의 리서치 사이언티스트인 네이선 램버트(Nathan Lambert)는 이번 개선에 대해 "기존의 벤치마크는 현실에서 벌어지는 인간의 복잡한 평가 기준을 충분히 반영하지 못했다"며, "새로운 버전에서는 전보다 훨씬 어렵고 다양한 프롬프트를 도입해 실제 사용 맥락과 긴밀히 연결된 평가가 가능하다"고 강조했다. RewardBench 2는 정확성, 수학, 명령 수행 능력, 안전성, 집중도 등 6개 영역으로 모델을 평가하며, 기업별 응용 분야에 따라 최적의 모델 선택을 돕는다.

특히 이번 버전은 이전에 공개되지 않았던 인간 프롬프트와 새로운 도메인을 포함해 더욱 정교한 측정을 가능하게 한다. 이를 통해 단일 점수 외에도 특정 환경에서의 상대적 강점을 파악할 수 있어, 기업의 요구에 맞춘 모델 선별이 쉬워진다. 램버트는 "리워드 모델이 기업 가치와 제대로 부합하지 않으면 오히려 허위 정보나 위험한 응답에 높은 점수를 줄 수 있다"며 정밀한 평가 기준의 중요성을 강조했다.

실제 벤치마크 테스트 결과에서는 Llama-3.1 계열의 지시형 모델들이 전반적으로 우수한 성능을 보인 것으로 나타났다. 팩트 기반 정확성 측면에서는 Ai2의 자체 모델인 Tulu가 두각을 드러냈고, 안정성과 집중력 평가에는 Skywork 데이터셋이 효과적인 것으로 분석됐다. 또한, RewardBench 2는 추론 시간 스케일링이나 데이터 필터링과 같이 RLHF 외의 상황에서도 실질적인 활용 가능성이 입증되었다.

RewardBench 프로젝트는 2024년 3월 처음 시작되었으며, 그 이후 메타(META)의 ‘reWordBench’, 딥시크(DeepSeek)의 ‘Self-Principled Critique Tuning’ 등 다양한 경쟁 기술들이 등장했다. 하지만 RewardBench 2는 현장 적용성을 중심에 두고 설계된 만큼, 실무 관점에서 차별화된 도구로 평가받고 있다.

Ai2 측은 여전히 벤치마크 점수가 모델 선택의 절대 지표가 되어서는 안 된다고 강조한다. 다만 RewardBench 2는 현실에 기반한 다차원 검증을 통해 기업별 니즈에 최적화된 AI 전략 수립을 가능하게 해 줄 도약의 발판이 될 수 있다고 밝혔다. AI 모델 선택과 평가에 있어 산업계가 한층 정교하고 과학적인 접근을 시도하고 있다는 방증이다.

0

0

![[토큰분석] 블록체인 수익의 민낯: 상위 100개 체인 중 연매출 100만 달러 넘는 곳은 16개뿐](https://f1.tokenpost.kr/2026/03/lgrmjrk1bs.jpg)

![[크립토 인사이트 EP.23] 전쟁 속 비트코인만 올랐다…이란 공습이 증명한 '국가가 빼앗을 수 없는 돈'](https://f1.tokenpost.kr/2026/03/j5ovmevdat.jpg)

![[토큰포스트 칼럼] 폭격 속에 비트코인만 올랐다… 전쟁이 증명한 '국가가 빼앗을 수 없는 돈'](https://f1.tokenpost.kr/2026/03/xpm9uaxwlx.webp)

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 544회차](https://f1.tokenpost.kr/2026/03/vljjplabhq.jpg)

![[토큰포스트] 기사 퀴즈 543회차](https://f1.tokenpost.kr/2026/02/u4blgenuev.jpg)

![[토큰포스트] 기사 퀴즈 542회차](https://f1.tokenpost.kr/2026/02/ybgphvyjr7.jpg)

![[토큰포스트] 기사 퀴즈 541회차](https://f1.tokenpost.kr/2026/02/g27ndxvfxv.jpg)