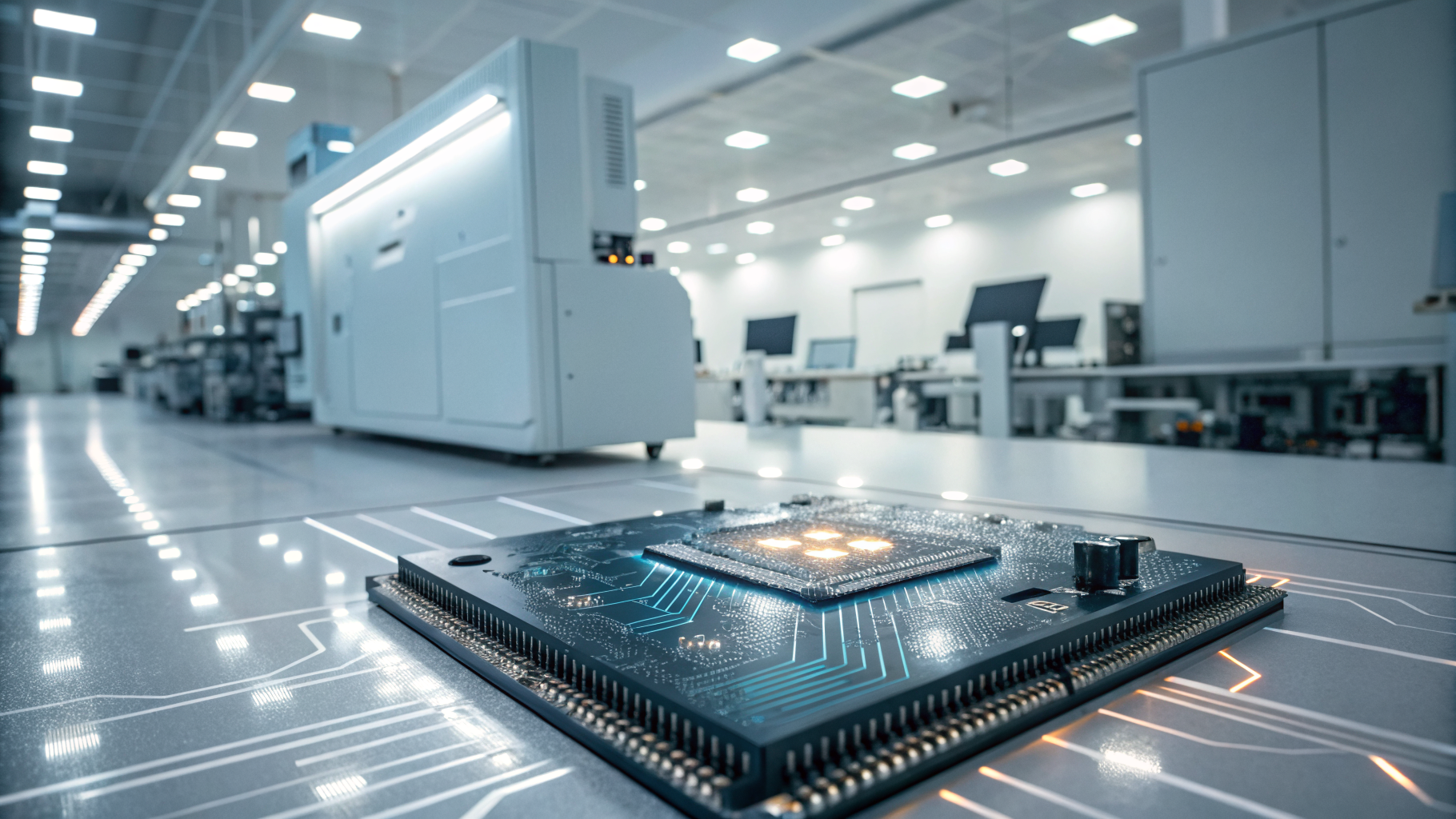

생성형 AI를 둘러싼 뜨거운 경쟁 속에서, 기업들은 고도화된 모델 구축에 몰두하면서 가장 핵심적인 요소인 데이터 보호에 대한 고려를 종종 간과하고 있다. 낮은 데이터 품질을 만회할 수 있는 AI 기술은 존재하지 않으며, 특히 데이터 보호를 무시한 인공지능 전략은 심각한 리스크를 초래할 수 있다는 지적이 나온다.

데이터는 AI 시스템의 ‘혈액’과 같다고 말하는 theCUBE 리서치의 스콧 헤브너는 고품질·고신뢰 데이터 없이는 AI가 정상적으로 작동할 수 없다고 강조했다. 그는 “AI는 정보 아키텍처 위에서 구동되며, 이런 시스템에서 데이터의 정확성, 처리 방식, 활용 범위, 보호 수준은 모두 설계 단계에서 고려돼야 할 필수 조건”이라고 설명했다. 단순한 데이터 보관을 넘어 법적 규제와 사이버 위협으로부터 안전하게 보호돼야 장기적인 AI 전략이 작동한다는 것이다.

실제로 기업 데이터의 상당수가 AI에 제대로 활용되지 못하는 상황이다. 헤브너는 “기업 대부분은 방대한 독점 데이터를 보유하고 있지만, 약 95%에 달하는 데이터가 AI에 쓰이지 못하고 있다”며 “가장 큰 장애물은 보안과 규제 리스크”라고 지적했다. 데이터가 있어도 보호 방안이 미비하면 활용 자체가 제한되거나 아예 배제되는 실정이라는 설명이다.

이처럼 AI에 적합한 데이터 기반을 만들기 위해서는 데이터 보호가 후속 작업이 아니라 초기 설계 단계부터 포함돼야 한다는 것이 전문가들의 강조점이다. 같은 세션에 참석한 크리스토프 베르트랑은 "AI는 단순 워크플로우나 워크로드가 아니라 전체 비즈니스에 영향을 주는 역동적 요소"라며 "AI와 관련된 모든 인프라는 설계 시점부터 보호 체계를 갖춰야 한다"고 밝혔다.

생성형 AI 에이전트와 자동화 기술이 생성하는 신생 데이터의 양이 폭증하는 현재 상황에서, 데이터 거버넌스는 시스템 확장성과 신뢰도 확보를 위한 필수 전제가 되고 있다. 이에 대해 헤브너는 “AI 시스템은 학습을 통해 고품질과 저품질, 보호된 데이터와 그렇지 않은 데이터를 구분할 수 있게 될 것”이라며 “AI 아키텍처 전반에 규제 준수, 내부 정책, 신뢰 프레임워크를 내장하는 것은 이제 기본이 돼야 한다”고 말했다.

AI 혁신을 눈앞에 둔 지금, 다수의 기업들이 이 과정을 뒷전으로 돌리는 것은 전략적 오판이 될 수밖에 없다. 데이터 보호는 단순한 보안 문제가 아닌 AI가 신뢰받고 효율적으로 작동하기 위한 전제 조건임을 잊어서는 안 된다.

0

0

![[토큰분석] 90% 빠진 토큰, 반등할까 사라질까… 5가지로 판별하는 법](https://f1.tokenpost.kr/2026/02/2bxkphkg67.jpg)

![[토큰포스트 칼럼] 주식시장이 블록체인 위로 올라간다… '인터넷 자본시장' 시대가 온다](https://f1.tokenpost.kr/2026/02/egp7zm9d1p.jpg)

![[토큰분석] 암호화폐 시장에서 '진짜 돈'이 빠지고 있다… USDT 시총이 보내는 경고 신호](https://f1.tokenpost.kr/2026/02/fnpcwelqa5.jpg)

![[토큰캠프 #3]](https://f1.tokenpost.kr/2026/02/2nft0e2jww.png)

![[마켓분석] 엔비디아, '어닝 서프라이즈' 넘어 '어닝 쇼크'… 매출 681억 달러·가이던스 780억 달러의 의미](https://f1.tokenpost.kr/2026/02/0etkh7qlwz.jpg)

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 541회차](https://f1.tokenpost.kr/2026/02/g27ndxvfxv.jpg)

![[토큰포스트] 기사 퀴즈 540회차](https://f1.tokenpost.kr/2026/02/s74dobfws9.jpg)

![[토큰포스트] 기사 퀴즈 539회차](https://f1.tokenpost.kr/2026/02/celz7zpk2n.jpg)

![[토큰포스트] 기사 퀴즈 538회차](https://f1.tokenpost.kr/2026/02/jxqkx5yb5c.jpg)

![[사설] 암호화폐는 인간을 위해 설계된 것인가](https://f1.tokenpost.kr/2026/02/foap58e60r.jpg)