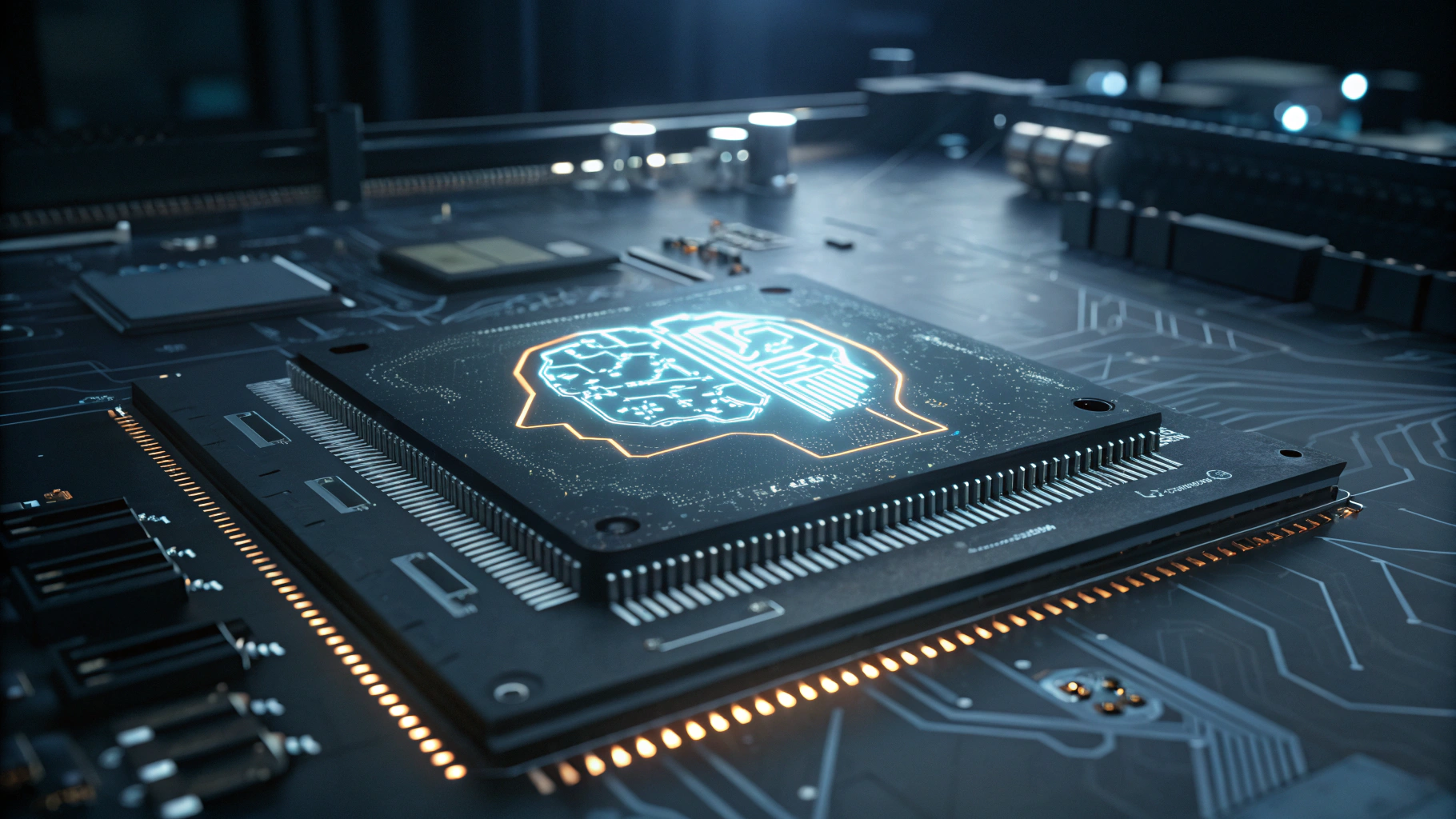

샌프란시스코에 본사를 둔 AI 스타트업 딥 코지토(Deep Cogito)가 스스로 추론 능력을 개선하는 4종의 차세대 오픈소스 대형 언어모델(LLM)을 전격 공개했다. 구글 출신 엔지니어들이 창업한 이 회사는 Cogito v2라는 시리즈로 총 70억~6710억 파라미터 규모의 모델을 내놨으며, 이중 일부는 제한있는 오픈 라이선스로, 나머지는 완전한 오픈소스로 제공된다.

해당 모델들은 특히 시간이 지날수록 스스로 더 나은 사고 과정을 학습하고, 이로 인해 점점 더 효율적인 추론 결과를 낼 수 있도록 설계됐다. 이른바 ‘머신 직관(machine intuition)’을 구조적으로 내재화한 구성이다. 딥 코지토는 이 과정에서 모델이 자신의 추론 경로를 단순 실행에 그치지 않고 학습 데이터의 일부로 다시 활용함으로써, 정답에 도달하는 사고 구조 자체를 지속적으로 정교화하도록 유도했다.

Cogito v2는 밀집(Dense) 버전과 전문가 혼합(MoE) 구조의 두 계열로 구성되며, 후자는 적은 컴퓨팅 자원으로도 더 높은 성능을 구현할 수 있는 것이 특징이다. 대표 모델인 6710억 파라미터 규모의 MoE 버전은 기존 오픈소스 벤치마크 모델 대비 60% 더 짧은 추론 경로로 동등하거나 높은 성능을 달성했다.

딥 코지토는 이들 모델을 허깅페이스(Hugging Face), Unsloth, 그리고 Together AI, 비스텐(Baseten), RunPod 등의 API 파트너 채널을 통해 제공하며, 경량화된 FP8(8비트 부동소수점) 버전도 함께 공개해 실시간 응답성과 비용 효율성을 고려한 다양한 옵션을 마련했다.

특히 주목할 점은 이러한 복잡한 모델을 포함한 딥 코지토의 전체 LLM 개발 비용이 350만 달러(약 50억 원) 이하라는 점이다. 오픈AI(OpenAI)의 GPT-4 훈련에 소요된 최대 1억 달러 대비 파격적인 수준이며, 기반 인프라에는 약 1000회의 훈련 실험과 데이터 자체 생성, 강화학습 등의 과정이 포함됐다.

딥 코지토의 CEO 드리샨 아로라(Drishan Arora)는 “더 똑똑한 모델을 만드는 데 있어 핵심은 토큰의 양이 아니라 추론 경로의 질”이라고 강조했다. 이러한 접근은 기업 고객이나 연구자들이 고성능 AI를 비용 효율적으로 운용할 수 있는 유리한 해법이 될 수 있다.

이번 발표로 딥 코지토는 단순히 또 하나의 오픈소스 모델을 소개한 것을 넘어, AI가 생각하는 방식 자체를 진화시킬 수 있다는 개념을 제시했다. 아로라는 이를 ‘힌트(hill-climbing)’ 방식에 비유하며 모델을 훈련하고, 그 추론 경로를 정제한 뒤, 이를 다시 다음 모델로 확장하는 생태계적 반복 프로세스로 설명했다.

실제로 현재 공개된 Cogito v2 모델들은 추상적 사고, 다단계 연산, 법리 해석 등에서 탁월한 성과를 보였으며, 판단 근거를 명확히 제시하는 해석 기반 추론 면에서도 기존 모델의 한계를 넘어섰다.

또한 “앨리스가 밥의 어머니이고, 밥이 찰리의 아버지일 때, 앨리스는 찰리에게 어떤 관계인가?” 같은 다단계 질문에서도 Cogito v2는 일반적인 모델이 자주 혼란을 겪는 지시어 해석 오류 없이 정확한 답을 도출했다.

딥 코지토는 향후에도 모든 모델을 오픈소스로 공개할 계획이며, 벤치마크의 승자가 되는 것보다 더 나은 사고법을 배우는 모델을 개발하는 것이 장기적 목표라고 밝혔다. 이를 위해 지속적으로 모델을 훈련하고, 그들이 스스로 추론한 방식을 다시 학습하는 구조를 반복하며 AI 발전의 새로운 방향을 제시하고 있다.

0

0

![[토큰포스트 인터뷰]](https://f1.tokenpost.kr/2026/02/f8yj0wqsum.jpg)

![[토큰포스트 칼럼] 코인베이스가 멈춘 날, 우리가 다시 깨달은 것](https://f1.tokenpost.kr/2026/02/byswkts2ac.png)

![[토큰포스트 인터뷰]](https://f1.tokenpost.kr/2026/02/d4iu4io7ux.jpg)

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 534회차](https://f1.tokenpost.kr/2026/02/qetvwueue8.webp)

![[토큰포스트] 기사 퀴즈 533회차](https://f1.tokenpost.kr/2026/02/yxki8fbsgk.webp)

![[토큰포스트] 기사 퀴즈 532회차](https://f1.tokenpost.kr/2026/02/geibni8f8j.jpg)

![[토큰포스트] 기사 퀴즈 530회차](https://f1.tokenpost.kr/2026/02/wzoyk1y2ly.jpg)