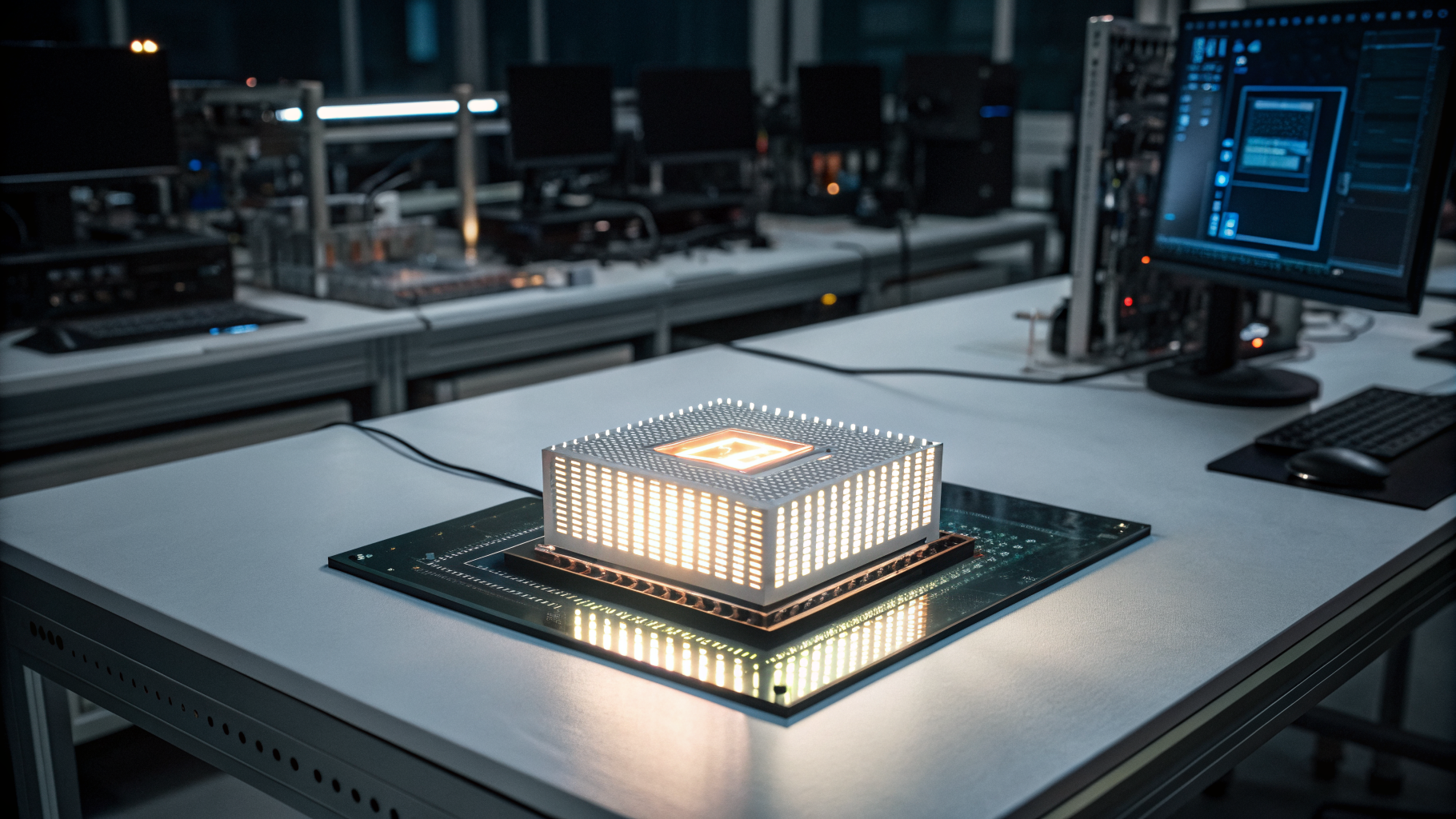

딥러닝 인공지능 모델을 더 짧은 시간 안에 운용할 수 있는 기술이 개발되면서, AI 시스템 효율성 향상에 한 걸음 다가섰다. 울산과학기술원(UNIST) 연구진은 AI 모델 최적화 과정에서 시간과 자원 소모를 크게 줄일 수 있는 기법을 선보였다.

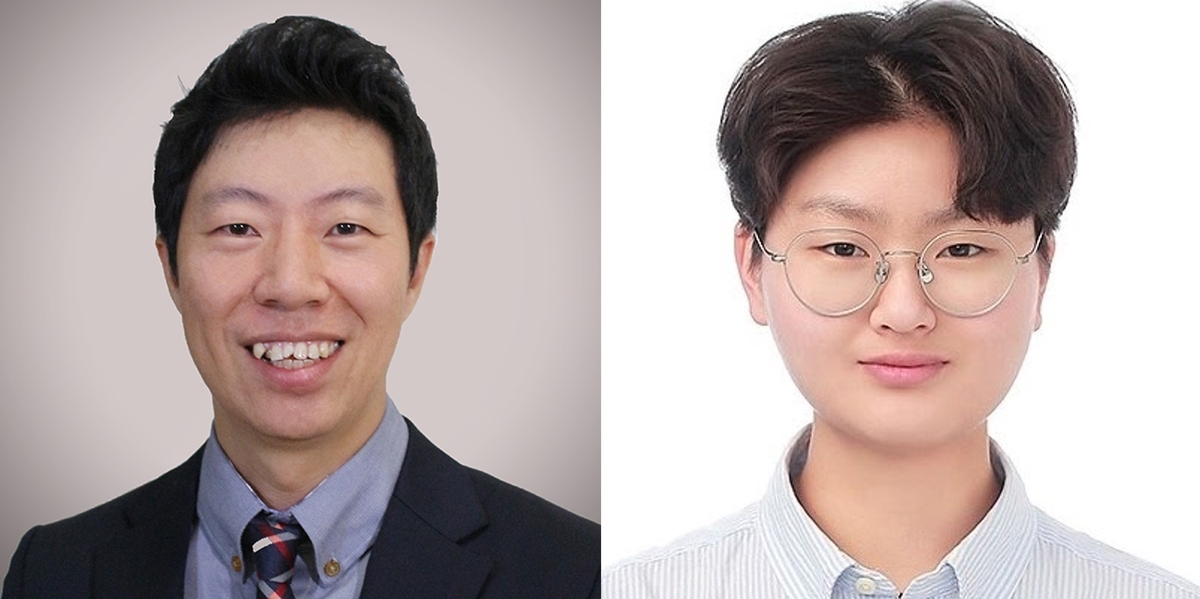

이번 연구는 UNIST 컴퓨터공학과 이슬기 교수팀이 주도했다. 연구진은 딥러닝 모델 작동에 필수적인 컴파일 과정 중 자동 최적화 기술인 ‘오토튜닝’의 속도를 향상시키는 데 초점을 맞췄다. 오토튜닝은 수많은 코드 조합 중에서 가장 빠르고 효율적인 코드를 자동으로 골라주는 기술이다. 하지만 이 작업은 계산량이 방대해, 경우에 따라 수십 분에서 수 시간까지 걸릴 수 있는 문제점이 있었다.

이슬기 교수팀은 AI 연산 과정에서 동일한 계산 구조가 반복된다는 점에 주목했다. 이에 따라 유사한 연산자 간 정보를 공유해 코드 조합 탐색 과정의 반복을 줄이는 방식을 개발했다. 단순히 매번 새로운 조합을 찾는 대신, 이전에 얻은 결과를 재활용함으로써 전체 연산 부담과 소요 시간을 줄인 방안이다.

이 기술은 CPU와 GPU 모두에서 성능 향상을 입증했다. 새롭게 개발된 기법을 오토튜닝 프레임워크에 적용한 결과, 동일한 실행 코드를 생성하는 데 걸리는 시간이 CPU 기준 평균 2.5배, GPU 기준 평균 2배 빨라졌다. 이 교수는 “컴파일 시간이 단축되면서 제한된 연산 자원을 보다 효율적으로 사용할 수 있고, 전력 소모도 감소하는 효과를 기대할 수 있다”고 설명했다.

이번 연구 성과는 지난 7월 7일부터 사흘간 미국 보스턴에서 열린 컴퓨터 시스템 분야 주요 학회 OSDI에서 발표됐다. 해당 학회는 운영 체제 설계와 성능 향상 기술을 다루는 국제적인 무대로, 이 연구가 세계적으로도 주목받고 있음을 보여준다.

딥러닝 산업은 연산 처리 속도가 서비스 품질과 직결되는 분야인 만큼, 이번 기술은 AI 상용화와 클라우드 기반 인프라 운영 비용 절감에도 긍정적 영향을 미칠 수 있다. 향후 AI 모델의 크기가 더욱 커지고 복잡해질수록, 이러한 최적화 기술의 중요성은 더욱 커질 전망이다.

0

0

![[크립토 인사이트 #16] 비트코인 STH 9만 달러 붕괴 속 '극단적 공포'…물밑에선 '1경 7천조' 토큰화 머니 혁명 진행 중](https://f1.tokenpost.kr/2026/02/jpd20aq4ge.jpg)

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 536회차](https://f1.tokenpost.kr/2026/02/3zpnuqh8qh.jpg)

![[토큰포스트] 기사 퀴즈 535회차](https://f1.tokenpost.kr/2026/02/h11k1htgnt.jpg)

![[토큰포스트] 기사 퀴즈 534회차](https://f1.tokenpost.kr/2026/02/qetvwueue8.webp)

![[토큰포스트] 기사 퀴즈 533회차](https://f1.tokenpost.kr/2026/02/yxki8fbsgk.webp)