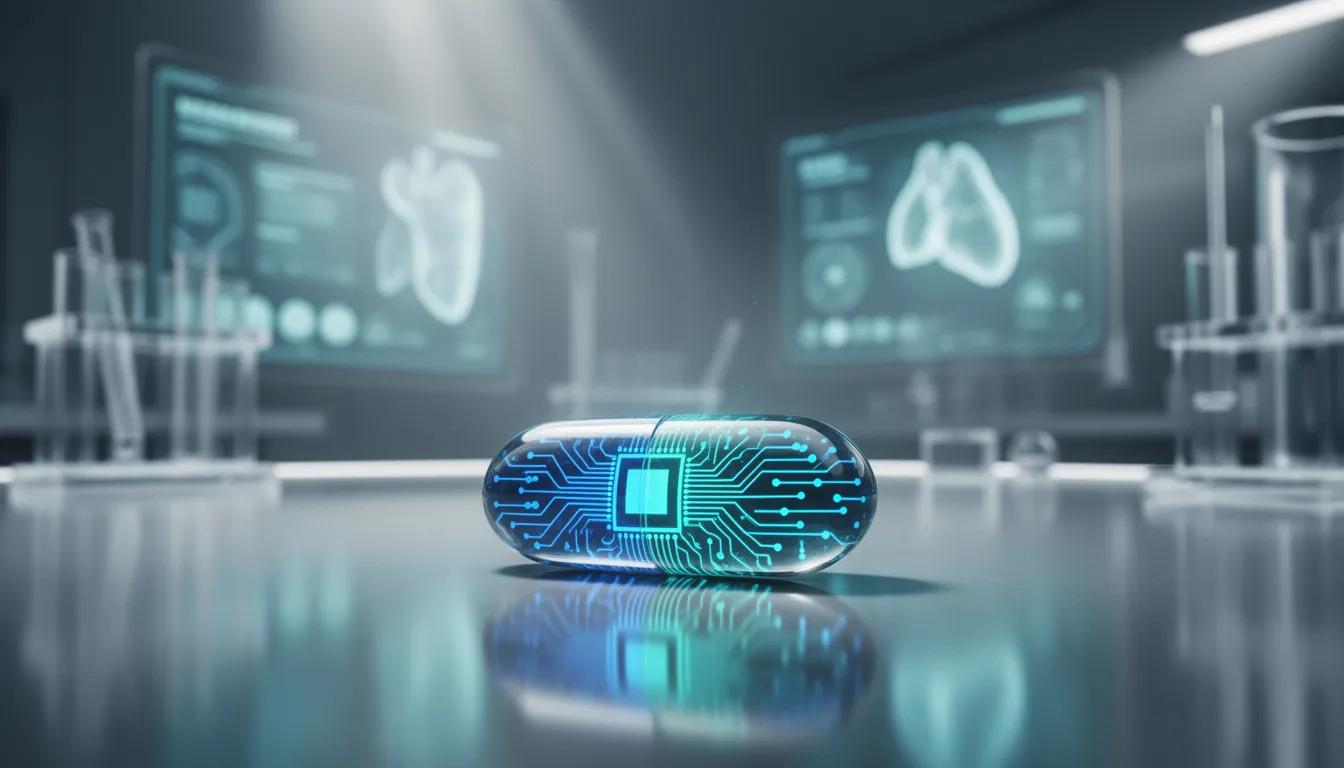

Nvidia가 새롭게 선보인 Spectrum-XGS 이더넷 기술이 차세대 인공지능(AI) 시스템 구축의 판도를 바꾸고 있다. AI 학습용 GPU 기술이 비약적으로 발전하고 있지만, 여전히 병목으로 작용하는 요소는 바로 네트워크 인프라다. 특히, 고성능 컴퓨팅 환경에서 여러 데이터센터를 연결해 초대규모 AI 팩토리를 구성하려면, 네트워크의 재설계가 필수적이다. 이 점에서 스펙트럼-XGS는 AI가 직면한 인프라 확장 한계를 본질적으로 해소하려는 시도라고 할 수 있다.

일반적인 이더넷 구조는 기존 데이터센터 내 단일 랙 수준에서 연결 요구를 충족시키는 데는 무리가 없지만, 수천 개의 GPU가 동시에 대량의 데이터를 주고받는 대규모 AI 모델 환경에서는 성능 한계를 드러낸다. 트래픽 폭주, 지연 시간 증가, 경로 불균형 등 다양한 문제가 발생하면서 GPU 자원이 비효율적으로 낭비된다. 이를 해결하고자 Nvidia는 멀티 데이터센터를 단일 AI 시스템처럼 작동시키는 ‘스케일 어크로스(scale-across)’ 아키텍처를 지원하는 Spectrum-XGS 이더넷을 내놨다.

핵심은 51.2Tbps의 대역폭을 제공하는 Spectrum-4 이더넷 스위치와 ConnectX-8 및 BlueField-3 SuperNIC의 조합이다. 이들 구성 요소는 각각의 데이터 패킷을 실시간으로 분석하고 경로 재조정 및 혼잡 제어를 통해 네트워크 부하를 분산시킨다. 여기에 Nvidia 소프트웨어가 결합돼 패킷 손실 없이 빠르고 안정적으로 GPU 간 통신을 가능하게 만들며, 지리적으로 분산된 데이터센터 간 통합 AI 팩토리 구현을 지원한다.

가장 중요한 성과는 대규모 언어모델(LLM) 학습 속도의 획기적인 개선에 있다. Nvidia는 해당 기술이 데이터센터 간 학습 시 기존 대비 약 2배의 성능 향상을 제공한다고 밝혔다. 이는 모델 훈련 시간을 크게 줄이며, 기업들이 더 빠르게 AI 서비스를 개발하고 배포할 수 있게 만든다. 경쟁이 극심한 AI 시장에서 몇 시간 단축된 훈련 주기는 곧 시장 선점과 직결되기 때문에, Spectrum-XGS의 가치는 단순한 하드웨어 혁신 그 이상이다.

경제적 측면에서도 효과는 뚜렷하다. 기존 인피니밴드 솔루션과는 달리, 스펙트럼-XGS는 이더넷 기반이라 기존 데이터센터 네트워크와의 통합이 유연하다. 표준화된 기술로 운용 효율은 높이고, 전용 솔루션 대비 구축 비용 또한 낮출 수 있어 총소유비용(TCO)을 줄이는 데 유리하다. 또한, 실시간 모니터링과 예측 유지보수를 통해 시스템 가동률 및 성능 안정성도 향상된다.

결국 Nvidia Spectrum-XGS 이더넷은 AI 인프라의 지리적 제약 문제를 해소함으로써 차세대 AI 시대의 확장을 가능케 하는 기반 기술로 떠오르고 있다. 물리적 공간이 제한적인 상황에서 대체 수단으로 활로를 제시하는 동시에, 누구보다 빠르게 경쟁 우위를 확보하려는 기업들에 새로운 선택지를 제공한다. 이는 단순한 속도 경쟁에서 벗어나, AI 아키텍처 설계 패러다임 자체를 근본적으로 전환하려는 Nvidia의 전략적 행보로 평가된다.

0

0

![[주간 뉴스브리핑] 이란 이슬람혁명수비대, 미국 및 동맹국 군사 시설에 공격 개시 外](https://f1.tokenpost.kr/2026/03/sc3wrib75u.jpg)

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 547회차](https://f1.tokenpost.kr/2026/03/4i8acp5kqv.png)

![[토큰포스트] 기사 퀴즈 546회차](https://f1.tokenpost.kr/2026/03/p1jfeb06y7.jpg)

![[토큰포스트] 기사 퀴즈 545회차](https://f1.tokenpost.kr/2026/03/yzt2egy26e.jpg)

![[토큰포스트] 기사 퀴즈 544회차](https://f1.tokenpost.kr/2026/03/vljjplabhq.jpg)