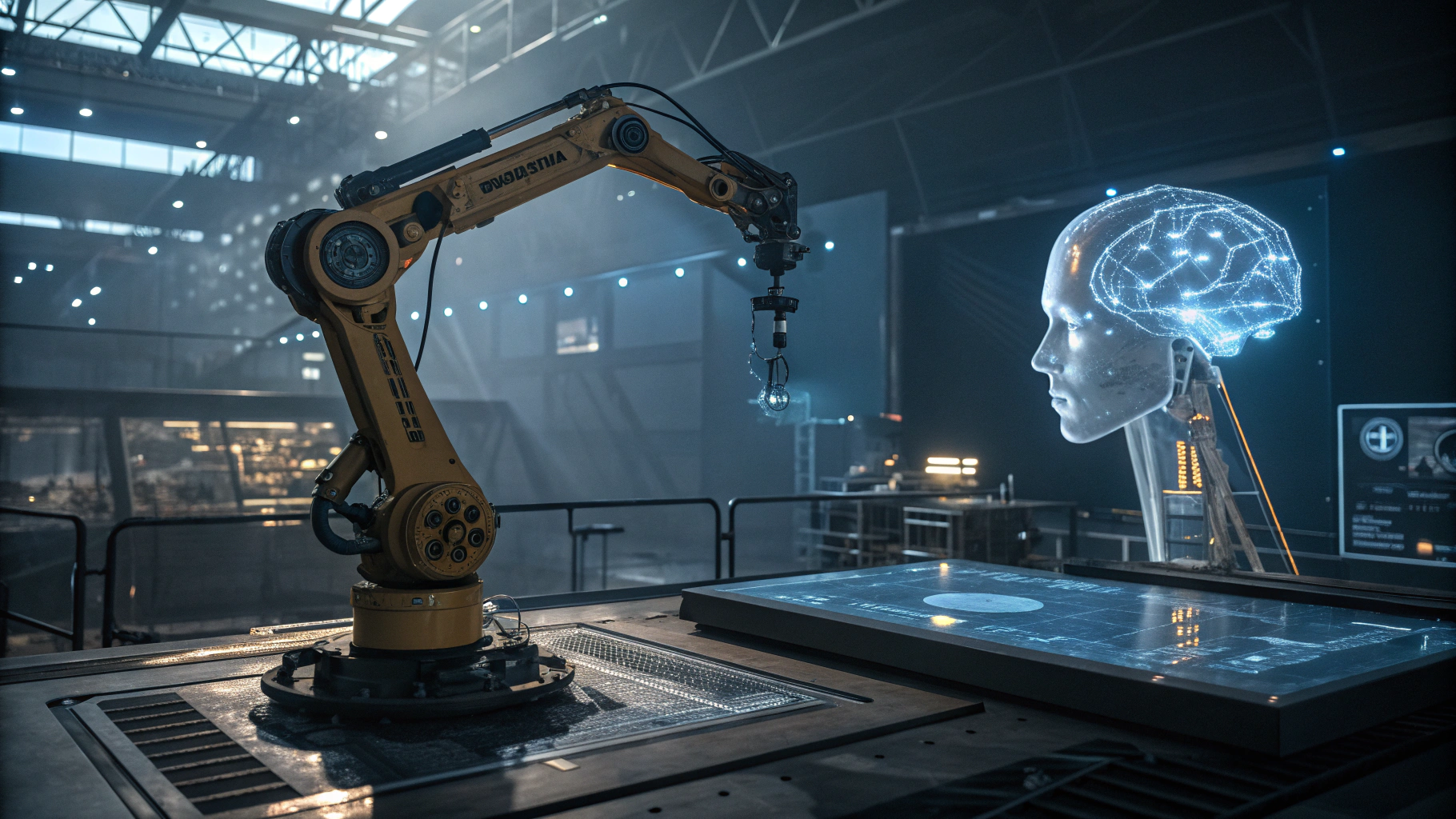

시애틀에 본사를 둔 AI 연구기관 앨런 인공지능 연구소(Ai2)가 새로운 로보틱스용 AI 모델 ‘MolmoAct 7B’를 공개하며 인간 수준의 공간 추론 능력을 로봇에 부여하는 혁신의 포문을 열었다. 이 모델은 로봇이 실제 움직임을 취하기 전, 3D 공간에서 계획(plan)을 수립할 수 있도록 설계됐다.

기존에도 AI는 이미지나 영상을 인식하고 이를 바탕으로 분석하거나 문장을 해석해 간단한 명령을 수행할 수 있었다. 하지만 대부분은 시각적 정보를 단순히 변환해 주어진 문장에 따라 행동하는 수준에 머물러 있었다. 반면 MolmoAct는 고차원적 문맥 이해력과 공간 인지 능력을 결합해, 주어진 명령을 미리 구상하고 실제 환경에서의 실행 계획을 완전한 3D 형태로 시뮬레이션하는 ‘행동 추론 모델(ARM)’이다.

Ai2의 최고경영자 알리 파라디(Ali Farhadi)는 이에 대해 “MolmoAct는 단순한 모델이 아니라 물리적 세계 속에서 AI가 실제로 이성적으로 사고하고 움직일 수 있는 기반을 마련하는 것”이라며, 로보틱 AI의 다음 진화를 상징한다고 설명했다.

MolmoAct는 총 70억 개의 파라미터를 기반으로 구동되며, 1800만 개의 트레이닝 샘플을 활용해 엔비디아(NVDA)의 H100 GPU 256개로 하루 만에 사전학습을 완료했다. 동시에 의료, 가정, 물류 환경 등 다양한 실세계 공간에서 수집된 1만 2000개의 로봇 작동 시나리오를 통해 목표 기반의 실제 작업 능력을 익혔다.

Ai2는 MolmoAct의 가장 큰 차별점으로 완전한 투명성을 꼽는다. 대부분의 AI 모델이 정작 내부 작동 원리를 외부에 공개하지 않고 '블랙박스'처럼 작동하는 것이 일반적인 반면, MolmoAct는 모델 가중치와 소스코드를 모두 공개해 연구자와 개발자 누구나 분석 및 수정을 할 수 있도록 했다. 실제로 사용자는 로봇 팔이 취하려는 경로를 카메라 이미지 위에 경로로 보여주는 방식으로 동작 계획을 사전에 확인하고, 터치스크린이나 자연어로 계획을 조정할 수도 있다.

Ai2는 이를 통해 병원, 창고, 가정 등 다양한 환경에 맞춰 로봇을 정밀하게 제어할 수 있으며, 이는 사람과 로봇 간 협업을 가능하게 하는 핵심 도약이라고 강조했다. AI 연구 팀장인 란제이 크리슈나(Ranjay Krishna)는 “MolmoAct는 환경을 3D로 실시간 재구성한 뒤 로봇의 관절과 팔이 행동할 경로를 계획하고 나서야 행동을 개시한다”며, 단순 뷰어형 모델과는 완전히 다른 작동 구조임을 밝혔다.

모델 검증 면에서도 뛰어난 성과를 보였다. SimPLER 벤치마크 테스트에서 72.1%의 작업 성공률을 기록하며, 구글(GOOGL), 마이크로소프트(MSFT), 엔비디아(NVDA) 등 업계 선발 업체들의 현행 모델을 상회했다. Ai2 측은 누구라도 이 모델을 내려받아 목적에 맞게 파인튜닝하거나 바로 실습할 수 있도록 하는 것이 목표라고 말했다.

MolmoAct는 로보틱스 AI의 차세대 핵심 모델이자 오픈소스 AI 발전 흐름 속에서 깊이를 더할 수 있는 이정표로 평가받고 있다. 이처럼 공개성과 실용성, 고급 추론력을 모두 갖춘 AI 기반 로봇 뇌는 향후 자동화 기술의 주류가 될 것으로 기대된다.

0

0

![[크립토 인사이트 EP.20] 비트코인 4만8천달러 시나리오 vs M2 재확장…공포 속 데이터는 무엇을 말하나](https://f1.tokenpost.kr/2026/02/we0wgyifi8.jpg)

![[토큰분석] 암호화폐 시장에서 '진짜 돈'이 빠지고 있다… USDT 시총이 보내는 경고 신호](https://f1.tokenpost.kr/2026/02/fnpcwelqa5.jpg)

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 541회차](https://f1.tokenpost.kr/2026/02/g27ndxvfxv.jpg)

![[토큰포스트] 기사 퀴즈 540회차](https://f1.tokenpost.kr/2026/02/s74dobfws9.jpg)

![[토큰포스트] 기사 퀴즈 539회차](https://f1.tokenpost.kr/2026/02/celz7zpk2n.jpg)

![[토큰포스트] 기사 퀴즈 538회차](https://f1.tokenpost.kr/2026/02/jxqkx5yb5c.jpg)