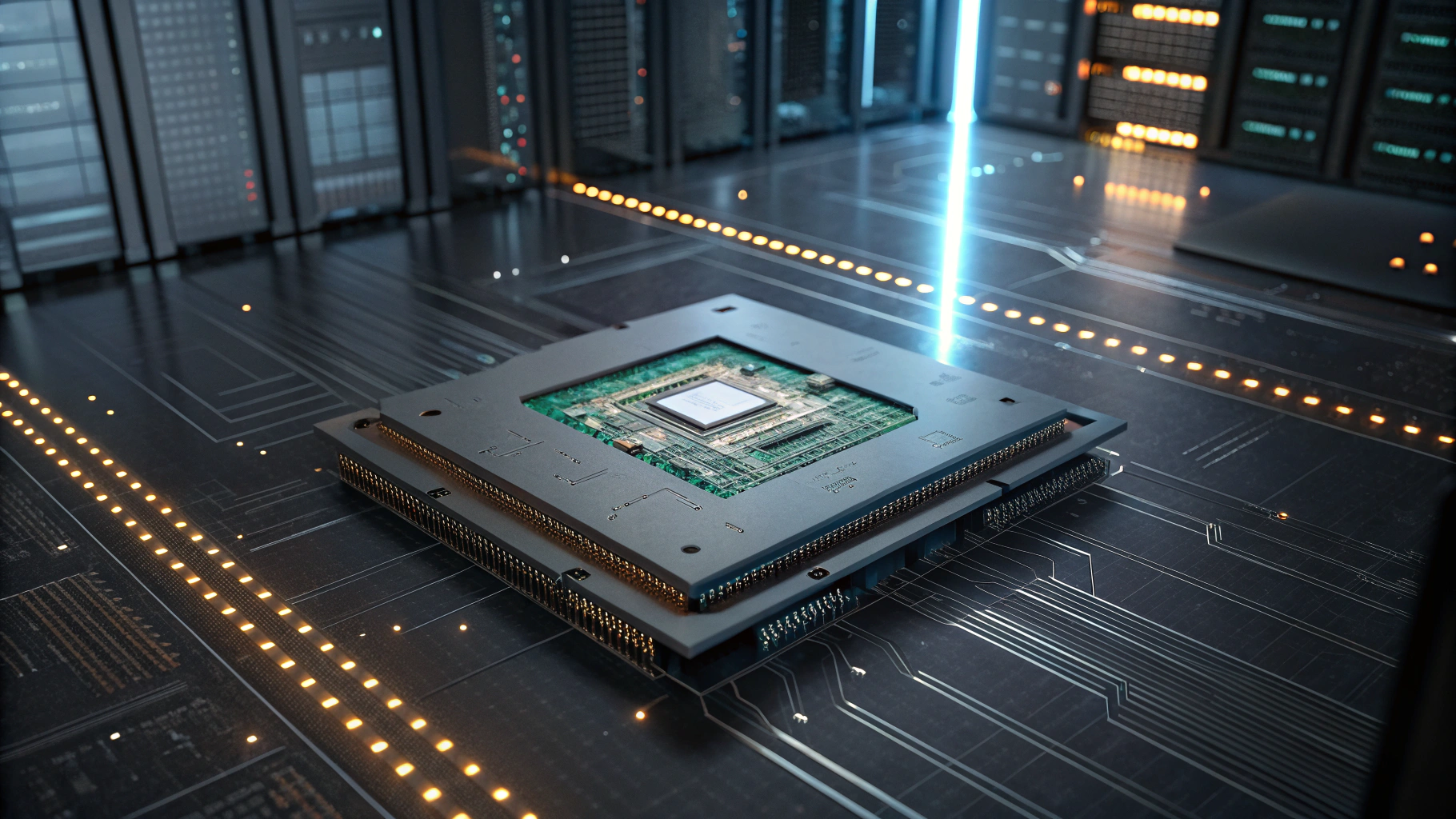

실리콘 웨이퍼 기반 AI 칩으로 엔비디아를 정면 겨냥해온 세레브라스 시스템즈(Cerebras Systems)가 이번에는 LLM 추론 분야에서 획기적인 이정표를 세웠다. 세레브라스는 최근 자사의 클라우드 기반 AI 인퍼런스 플랫폼에서 실시간 고급 추론을 구현할 수 있는 최신 모델인 Qwen3-32B를 공개하며, GPU 중심의 기존 프레임워크가 가진 한계를 뛰어넘었다고 강조했다.

Qwen3-32B는 중국 알리바바가 개발한 오픈웨이트 기반 초거대 언어 모델로, GPT-4.1이나 DeepSeek R1과 견줄 수 있는 수준의 성능을 보여주는 동시에, 폐쇄형 모델과 달리 완전 공개된 형태로 제공된다. 세레브라스는 이 모델이 자사 인퍼런스 플랫폼에서 최대 1.2초만에 추론 결과를 반환할 수 있다고 밝히며, 이는 기존 GPU 기반 플랫폼 대비 속도 측면에서 최대 60배 빠른 성능이다.

이 같은 성능 개선의 핵심은 세레브라스가 직접 설계한 웨이퍼 스케일 엔진(WSE-3) 칩에 있다. 해당 칩은 5나노 공정 기반에 1.4조 개의 트랜지스터와 90만 개 이상의 코어를 탑재하고 있으며, 이는 엔비디아의 H100 GPU 대비 52배 많은 코어 수를 제공한다. 여기에 44GB의 정적 메모리(SRAM)를 온칩에 직접 구현해, 메모리 병목 현상을 근본적으로 해소했다는 점에서 차별화된다.

세레브라스는 이번 Qwen3-32B 통합으로 메타의 Llama 4를 비롯해 다양한 AI 모델에서도 최대 20배 이상의 인퍼런스 효율을 입증했다고 주장한다. 이러한 성능은 미스트랄 AI, 퍼플렉서티 AI 등 유망 AI 스타트업들의 채택 확대를 바탕으로 더욱 신뢰성을 얻고 있다.

가격 경쟁력도 주목할 만하다. 세레브라스는 Qwen3-32B 서비스 가격을 입력 100만 토큰당 40센트, 출력 100만 토큰당 80센트(약 1,150원)로 책정하면서, 동일 성능의 GPT-4.1 대비 약 10분의 1 수준의 요금이라는 점을 강조했다. 또한, 처음 시작하는 개발자들에게는 매일 백만 개의 무료 토큰을 제공하며, 별도의 대기 리스트 없이 즉시 사용 가능하다는 점도 장점이다.

세레브라스 창립자이자 CEO인 앤드루 파브먼(Andrew Farbman)은 “Qwen3-32B는 DeepSeek R1이나 오픈AI의 O-Series와 동등하거나 더 나은 수준의 추론 성능을 지녔다”며 “이제는 초고속 반응성을 갖춘 실시간 AI가 대중에게 손쉽게 제공 가능한 시대”라고 밝혔다.

AI 추론 성능이 실시간성을 확보하면서, 챗봇·비서·코파일럿·업무 자동화 기능 등 각종 인공지능 에이전트 서비스 구현에 있어 새로운 지평이 열리는 셈이다. 특히 복잡한 논리적 사고를 담은 컨텍스트 기반의 다단계 추론에 적합한 모델일수록 응답 지연이 치명적이었던 기존 구조에서 벗어나, 즉각적인 예측 및 실행이 가능해졌다는 점에서 업계 혁신이 기대된다.

세레브라스는 이번 출시를 통해 OpenAI 및 엔비디아 중심의 AI 생태계를 견제하며, 고성능이면서도 개방형 지향의 LLM 시장에서 점점 더 영향력을 확대해 나갈 것으로 관측된다.

0

0

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 542회차](https://f1.tokenpost.kr/2026/02/ybgphvyjr7.jpg)

![[토큰포스트] 기사 퀴즈 541회차](https://f1.tokenpost.kr/2026/02/g27ndxvfxv.jpg)

![[토큰포스트] 기사 퀴즈 540회차](https://f1.tokenpost.kr/2026/02/s74dobfws9.jpg)

![[토큰포스트] 기사 퀴즈 539회차](https://f1.tokenpost.kr/2026/02/celz7zpk2n.jpg)