AI 추론 스타트업 Groq가 두 건의 전략적 발표를 통해 클라우드 업계를 뒤흔들고 있다. 알리바바의 대규모 언어모델 Qwen3 32B의 전체 13만1,000 토큰 맥락(window) 지원과 함께, 오픈소스 AI 플랫폼 허깅페이스(Hugging Face)와의 공식 협력으로 수백만 글로벌 개발자에게 직접 자사의 기술을 제공할 수 있게 됐다. 이는 아마존웹서비스(AWS), 구글, 마이크로소프트(MSFT) 등 기존 클라우드 대기업들이 주도하고 있는 AI 추론 시장에 정면 도전장을 낸 셈이다.

Groq는 Qwen3 32B를 업계 최초로 전체 맥락 창을 지원하는 속도로 서비스함으로써 기존 추론 서비스들이 안고 있는 기술적 한계를 정면으로 돌파했다는 평가다. 독립 평가기관 인공지능 분석사에 따르면, 해당 서비스는 초당 약 535 토큰의 속도를 구현하며, 복잡한 문서 분석이나 지속적 대화형 AI 적용에 필요한 성능 기준을 만족시킨다.

비용 측면 역시 강점으로 부각된다. 입력 토큰 100만 개당 $0.29, 출력 토큰 100만 개당 $0.59의 가격 설정은 기존 주요 공급자 대비 효율적이라는 분석이다. Groq 관계자는 “전체 맥락 창을 구현할 수 있는 유일한 공급자는 Groq뿐이며, 대규모 AI 애플리케이션 개발에서 성능과 비용 모두를 만족시킬 수 있는 유일한 파트너가 될 것”이라고 강조했다.

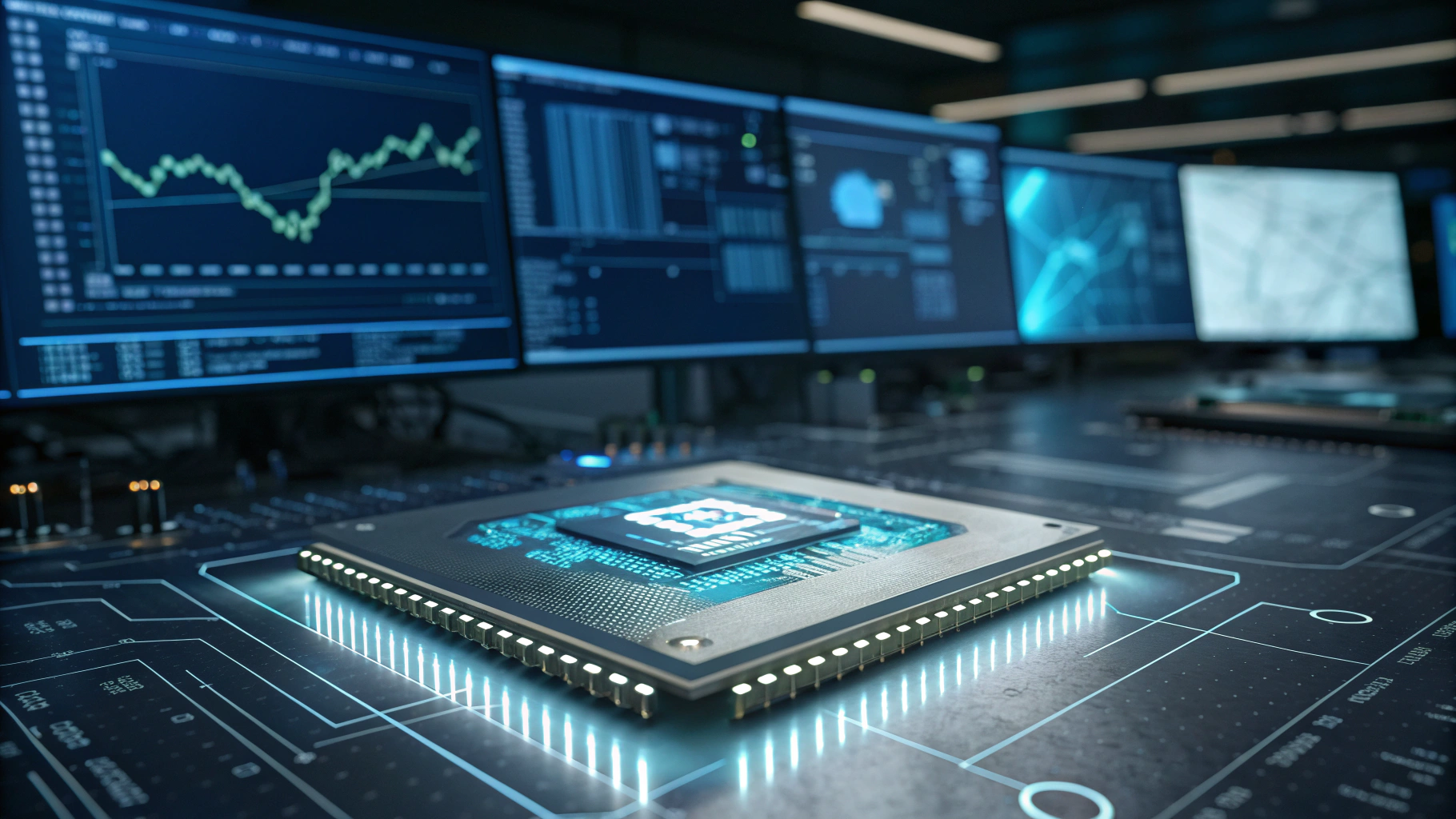

이러한 기술적 성과의 배경에는 Groq가 자체 개발한 언어처리반도체 ‘LPU(Language Processing Unit)’가 자리한다. GPU에 기반한 범용 연산보다 메모리 집약적인 자연어 추론에 특화된 LPU는 효율적 대규모 맥락 운용이 가능한 구조로, Groq의 차별성을 뒷받침한다는 설명이다.

동시에 Groq는 허깅페이스의 공식 '추론 제공자'로 등록되며 생태계 확장을 도모하고 있다. 허깅페이스는 전 세계 수백만 명의 개발자가 사용하는 오픈소스 AI 플랫폼으로, 이번 협력을 통해 사용자들은 번거로운 환경 설정 없이 바로 Groq를 활용한 추론 서비스를 API와 Playground 상에서 구동할 수 있게 됐다. 협업은 메타의 LLaMA 시리즈, 구글의 Gemma, 그리고 Qwen3 32B 등 다양한 주요 모델을 포괄한다.

허깅페이스와 Groq는 공동 성명을 통해 “이번 협력은 고성능 AI 추론의 민주화를 위한 중요한 진전”이라며, 사용성과 효율성을 동시에 개선할 수 있는 계기가 될 것이라고 평가했다.

다만, 이러한 확장은 규모에 따른 성능 유지라는 과제를 동반한다. Groq 측은 현재 미국, 캐나다, 중동 전역에 걸친 데이터센터 인프라를 통해 매초 2,000만 토큰 이상을 처리하고 있으며 글로벌 확장을 계획 중이라고 밝혔다. 하지만 AWS, 구글 클라우드, 마이크로소프트 애저와 같은 빅테크들은 이미 수십 년간 축적된 글로벌 인프라를 바탕으로 공격적인 AI 인프라 확장을 지속 중이다.

이와 관련해 Groq는 “현재 산업은 막 진입기에 불과하다. 우리가 올해 인프라를 두 배로 늘린다 해도 수요를 모두 감당하긴 부족할 것”이라며 AI 추론 시장의 폭발적 수요를 강조했다.

수익성 측면에서는 의문이 남는다. 마진이 얇은 고성능 AI 추론 시장에서, Groq는 낮은 단가 전략으로 대량 수요를 유인하며 규모의 경제를 통한 손익분기점을 추구하는 구조다. Groq 관계자는 “AI 솔루션의 폭넓은 도입 속도는 예상보다 빠르며, 우리는 인프라 확산을 통해 비용을 최대한 낮추는 동시에 추론 경제의 미래를 현실화하는 데 집중할 것”이라고 설명했다.

시장조사업체 그랜드뷰 리서치에 따르면, 글로벌 AI 추론 칩 시장은 2030년까지 1,549억 달러(약 223조 원) 규모로 성장할 전망이다. 기업 입장에서 Groq의 시도는 기회이자 리스크로 작용한다. 문서 분석, 법률 리서치, 복합적 의사결정 등에서 Groq의 장점은 분명하지만, 규모가 작은 공급자에 대한 지속 가능성 우려도 함께 고려될 수밖에 없다.

결국 Groq의 이번 발표는 고도화된 기술력과 대담한 전략이 대형 클라우드의 시장 지배력을 얼마나 돌파할 수 있는지를 시험하는 전환점이며, 개발자와 기업 모두에게 AI 추론 시장에 또 다른 선택지를 제시하고 있다.

1

1

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 529회차](https://f1.tokenpost.kr/2026/02/jnnmwwttwl.jpeg)

![[토큰포스트] 기사 퀴즈 528회차](https://f1.tokenpost.kr/2026/02/0l6qk9c4ub.jpg)

![[토큰포스트] 기사 퀴즈 527회차](https://f1.tokenpost.kr/2026/02/6ndj5dyz0f.jpg)

![[토큰포스트] 기사 퀴즈 526회차](https://f1.tokenpost.kr/2026/02/qhaxcpku8t.jpg)

![[토큰캠프 #2] 폭락장에서도 살아남는 법...](https://f1.tokenpost.kr/2026/02/82w7a5pnt1.jpg)

![[마켓분석] 2조 달러의 질문: 소프트웨어 섹터, '떨어지는 칼날'인가 '튀어 오르는 용수철'인가?](https://f1.tokenpost.kr/2026/02/6m5vuilwal.jpg)