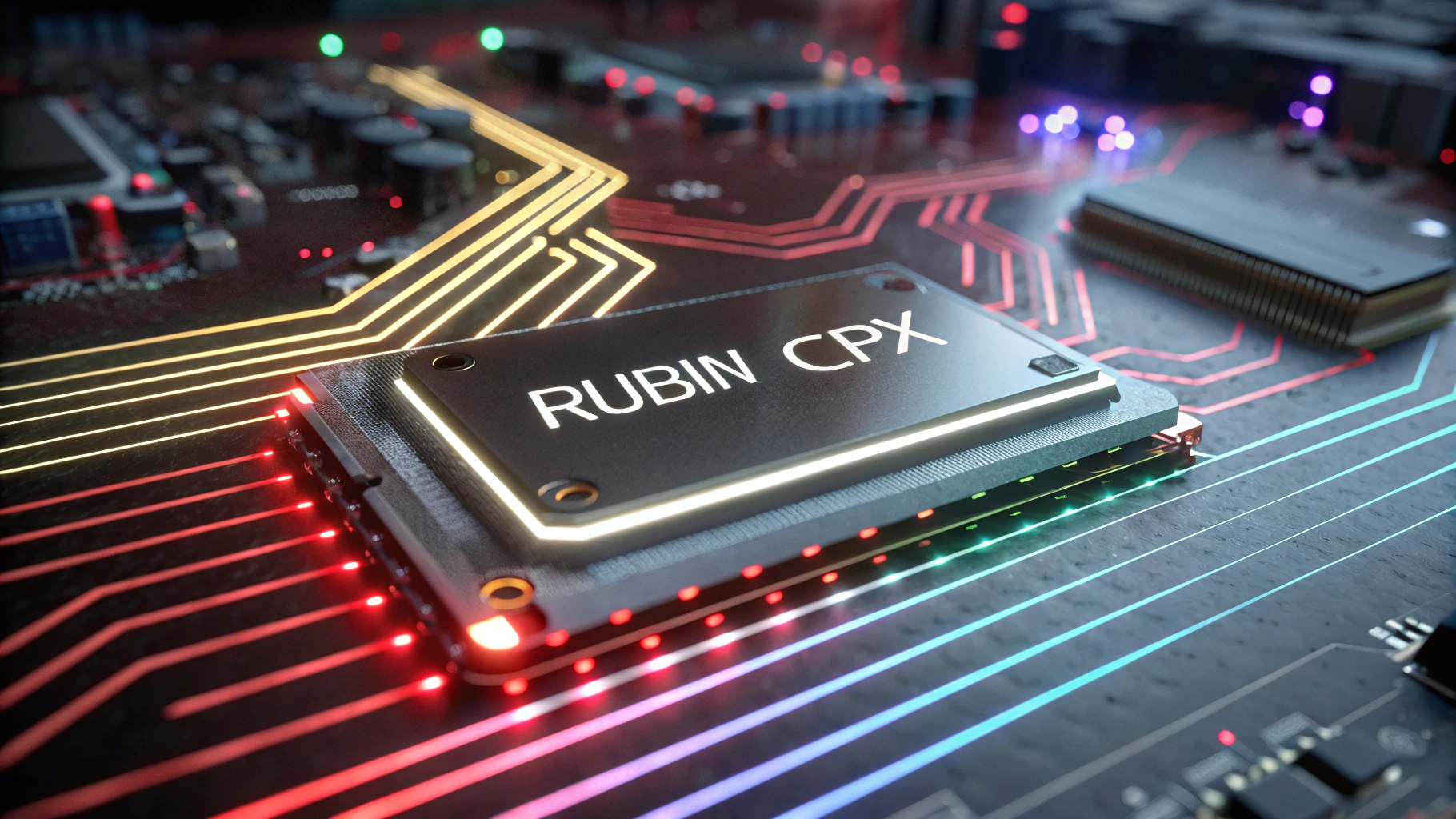

엔비디아(NVDA)가 AI 추론 워크플로우 혁신을 겨냥한 새로운 GPU ‘루빈 CPX(Rubin CPX)’를 공개하며 고성능 컴퓨팅 시장에 다시 한번 강하게 출사표를 던졌다. 2026년 말 출시를 목표로 하는 루빈 CPX는 전례 없는 8엑사플롭스(Exaflops) 급 연산 성능을 제공하며, 기존 AI 시스템 설계 방식을 근본부터 재편하고자 한다.

루빈 CPX가 지향하는 핵심 구조는 ‘디스어그리게이티드 추론(disaggregated inference)’이다. 기존 AI 시스템은 문맥 분석과 응답 생성 — 두 단계를 동일한 GPU에서 동시에 처리했지만, 엔비디아는 이 두 단계를 각기 다른 칩에 분산 배치해 처리 효율을 극대화하는 방식을 도입한다. 루빈 CPX는 이 가운데 전처리 역할을 맡는 이른바 ‘문맥(context) 처리’에 최적화된 신형 칩이다.

엔비디아는 루빈 CPX를 총 144개 탑재하고 여기에 응답 생성을 담당할 루빈 GPU 144개, 그리고 36개의 CPU를 결합한 고성능 시스템 ‘베라 루빈 NVL144 CPX’를 선보일 예정이다. 해당 시스템은 최대 8엑사플롭스, 즉 초당 100경 회 이상의 연산작업을 처리할 수 있어 현재 자사의 최상위 모델인 GB300 NVL72에 비해 7배 이상 빠른 성능을 구현한다.

루빈 CPX는 통합형 단일 다이(monolithic die) 설계를 채택했으며, 여기에 128GB의 최신 GDDR7 메모리를 탑재한다. 특히 대규모 언어 모델(LLM)에서 핵심 역할을 수행하는 ‘어텐션(attention)’ 기술 처리 속도를 기존 대비 3배 이상 향상시킨 점이 특징이다. 엔비디아 하이퍼스케일 및 HPC 부문 부사장 이안 벅(Ian Buck)은 “어텐션 처리 성능에 집중 투자해 LLM 처리 효율을 획기적으로 끌어올렸다”고 밝혔다.

동영상 처리 성능도 대대적으로 개선된다. 루빈 CPX는 하드웨어 수준에서 영상 인코딩과 디코딩을 지원하며, 이는 초대형 AI 모델이 한 시간 분량의 영상이나 수만 줄의 코드에 달하는 ‘100만 토큰’ 규모의 데이터를 실시간 분석해 고품질 결과물을 생성하는 데 기여한다.

엔비디아는 자사의 루빈 플랫폼을 통해 추론 시스템의 성능 한계를 끌어올리는 동시에, AI 반도체 시장에서 경쟁사와 격차를 더욱 벌리겠다는 전략이다. 특히 LLM의 활용도가 증가하고 대형 워크로드 수요가 급증하는 가운데, 루빈 CPX는 차세대 AI 인프라의 핵심 축으로 자리매김할 가능성이 높다.

루빈 CPX의 본격적인 출하는 2026년 4분기로 예정되어 있으며, 이와 함께 추론 가속기 분야에서 엔비디아의 기술 주도력이 다시금 집중 조명을 받을 것으로 전망된다.

0

0

![[Episode 12] IXO™2024 참여하고, 2억원 상당 에어드랍 받자!](https://f1.tokenpost.kr/2024/03/bk2tc5rpf6.png)

![[Episode 11] 코인이지(CoinEasy) 에어드랍](https://f1.tokenpost.kr/2024/02/g0nu4cmps6.png)

![[Episode 8] Alaya 커뮤니티 입장하고, $AGT 받자!](https://f1.tokenpost.kr/2023/10/0evqvn0brd.png)

![[Episode 6] 아트테크 하고, 에어드랍 받자!](https://f1.tokenpost.kr/2023/08/3b7hm5n6wf.jpg)

![[토큰포스트] 기사 퀴즈 522회차](https://f1.tokenpost.kr/2026/01/aims5420dh.jpg)

![[토큰포스트] 기사 퀴즈 521회차](https://f1.tokenpost.kr/2026/01/f2femcntpq.jpg)

![[토큰포스트] 기사 퀴즈 520회차](https://f1.tokenpost.kr/2026/01/y648ak216n.jpg)

![[토큰포스트] 기사 퀴즈 519회차](https://f1.tokenpost.kr/2026/01/k3bqfcj1o8.jpeg)